问题引入

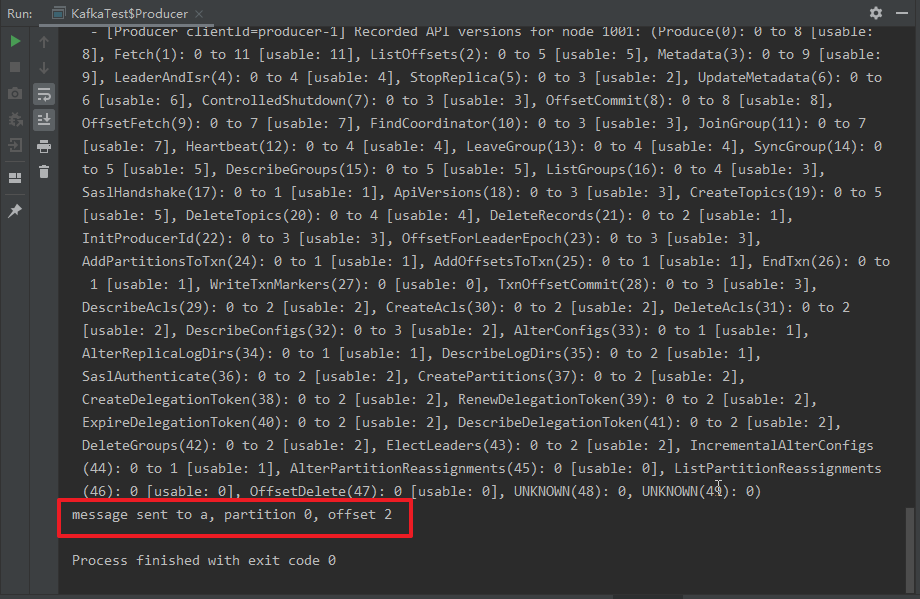

我在 main 方法中执行一个简单的(KafkaProducer发送数据,KafkaConsumer消费数据)测试的时候,

我只想查看一行输出,控制台却出现了很多烦人的日志。

于是,我想把这些日志去除掉。

点击查看(KafkaProducer发送数据,KafkaConsumer消费数据)测试代码

1 | package com.decathlon.sfc.order.bff.core.controller; |

解决方案

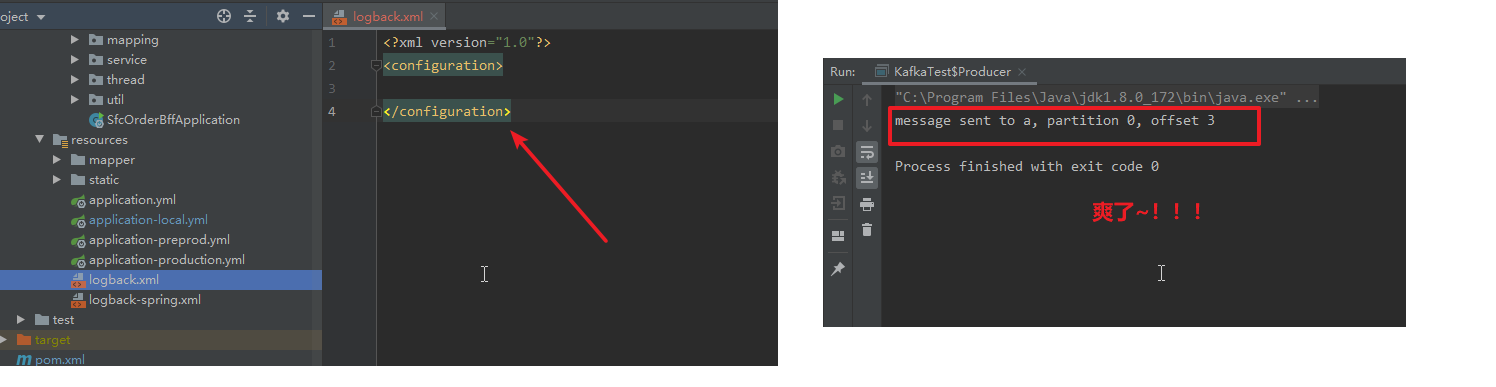

在src\main\resources下面加入文件logback.xml,内容如下(对,你没有看错,就是下面这个)

1 |

|