关于浏览过的文章

https://github.com/CL0610/Java-concurrency

http://www.dengshenyu.com/后端技术/2016/05/01/jmm-happens-before.html

https://www.jianshu.com/p/1508eedba54d

https://www.cnblogs.com/chenssy/p/6393321.html

https://www.jianshu.com/p/4853ad07e1ff

https://blog.csdn.net/yanluandai1985/article/details/82686486

https://www.cnblogs.com/zhangjk1993/archive/2017/03/29/6641745.html

https://blog.csdn.net/noodleprince/article/details/79711307

https://blog.csdn.net/javazejian/article/details/77410889

https://blog.csdn.net/luluyo/article/details/92403054

https://blog.csdn.net/hanchao5272/article/details/79779639

https://www.jianshu.com/p/19be99a6480a

关于synchronized具备原子性的问题

synchronized是”万能”的,为什么还需要volatile呢?

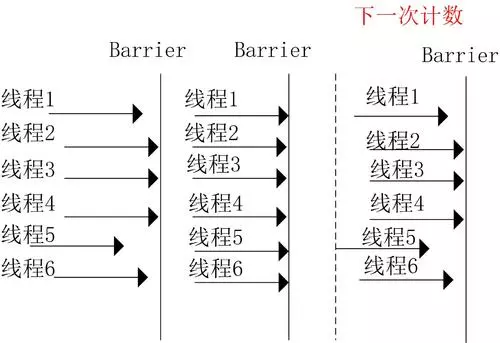

Java并发编程:Semaphore、CountDownLatch、CyclicBarrier

并发编程的优缺点

为什么要用到并发

一直以来,硬件的发展极其迅速,也有一个很著名的摩尔定律

因此,多核的CPU的背景下,催生了并发编程的趋势,通过并发编程的形式可以将多核CPU的计算能力发挥到极致,性能得到提升。

另外,在特殊的业务场景下先天的就适合于并发编程。

比如在图像处理领域,一张1024X768像素的图片,包含达到78万6千多个像素。即时将所有的像素遍历一边都需要很长的时间,面对如此复杂的计算量就需要充分利用多核的计算的能力。

又比如当我们在网上购物时,为了提升响应速度,需要拆分,减库存,生成订单等等这些操作,就可以进行拆分利用多线程的技术完成。

面对复杂业务模型,并行程序会比串行程序更适应业务需求,而并发编程更能吻合这种业务拆分 。

- 充分利用多核CPU的计算能力;

- 方便进行业务拆分,提升应用性能

并发编程有哪些缺点

多线程技术有这么多的好处,难道就没有一点缺点么,就在任何场景下就一定适用么?很显然不是。

频繁的上下文切换

时间片是CPU分配给各个线程的时间,因为时间非常短,所以CPU不断通过切换线程,让我们觉得多个线程是同时执行的,时间片一般是几十毫秒。

而每次切换时,需要保存当前的状态起来,以便能够进行恢复先前状态,而这个切换时非常损耗性能,过于频繁反而无法发挥出多线程编程的优势。

通常减少上下文切换可以采用无锁并发编程,CAS算法,使用最少的线程和使用协程。

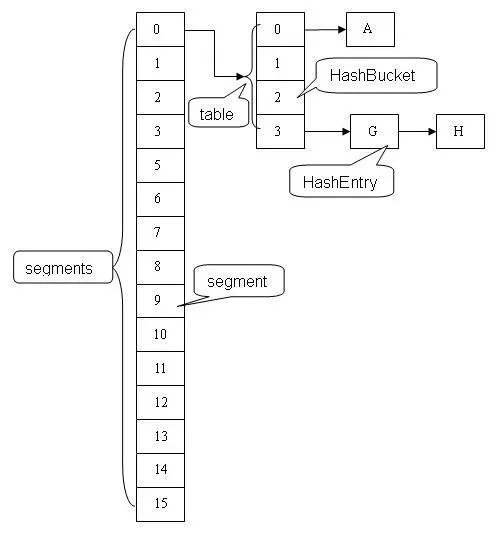

无锁并发编程可以参照concurrentHashMap锁分段的思想,不同的线程处理不同段的数据,这样在多线程竞争的条件下,可以减少上下文切换的时间。CAS算法利用Atomic下使用CAS算法来更新数据,使用了乐观锁,可以有效的减少一部分不必要的锁竞争带来的上下文切换使用最少线程避免创建不需要的线程,比如任务很少,但是创建了很多的线程,这样会造成大量的线程都处于等待状态协程在单线程里实现多任务的调度,并在单线程里维持多个任务间的切换

由于上下文切换也是个相对比较耗时的操作,所以在”java并发编程的艺术”一书中有过一个实验,并发累加未必会比串行累加速度要快。

可以使用Lmbench3测量上下文切换的时长 vmstat测量上下文切换次数

线程安全-死锁

多线程编程中最难以把握的就是临界区线程安全问题,稍微不注意就会出现死锁的情况,一旦产生死锁就会造成系统功能不可用。

代码示例

1 | public class DeadLockDemo { |

在上面的这个demo中,开启了两个线程threadA, threadB,其中threadA占用了resource_a, 并等待被threadB释放的resource_b。threadB占用了resource_b正在等待被threadA释放的resource_a。因此threadA,threadB出现线程安全的问题,形成死锁。

如上所述,完全可以看出当前死锁的情况。

避免死锁的情况

- 避免一个线程同时获得多个锁;

- 避免一个线程在锁内部占有多个资源,尽量保证每个锁只占用一个资源;

- 尝试使用定时锁,使用lock.tryLock(timeOut),当超时等待时当前线程不会阻塞;

- 对于数据库锁,加锁和解锁必须在一个数据库连接里,否则会出现解锁失败的情况

所以,如何正确的使用多线程编程技术有很大的学问,比如如何保证线程安全,如何正确理解由于JMM内存模型在原子性,有序性,可见性带来的问题,比如数据脏读,DCL(双重检验锁)等这些问题(在后续篇幅会讲述)。而在学习多线程编程技术的过程中也会让你收获颇丰。

应该了解的概念

同步VS异步

同步和异步通常用来形容一次方法调用。

同步方法调用一开始,调用者必须等待被调用的方法结束后,调用者后面的代码才能执行。异步用,指的是,调用者不用管被调用方法是否完成,都会继续执行后面的代码,当被调用的方法完成后会通知调用者。

例如同步调用在超时购物,如果一件物品没了,你得等仓库人员跟你调货,直到仓库人员跟你把货物送过来,你才能继续去收银台付款异步调用就像网购,你在网上付款下单后,什么事就不用管了,该干嘛就干嘛去了,当货物到达后你收到通知去取就好。

并发与并行

并发和并行是十分容易混淆的概念。

并发指的是多个任务交替进行并行是指真正意义上的“同时进行”。

实际上,如果系统内只有一个CPU,而使用多线程时,那么真实系统环境下不能并行,只能通过切换时间片的方式交替进行,而成为并发执行任务。

真正的并行也只能出现在拥有多个CPU的系统中。

阻塞和非阻塞

阻塞和非阻塞通常用来形容多线程间的相互影响

阻塞一个线程占有了临界区资源,那么其他线程需要这个资源就必须进行等待该资源的释放,会导致等待的线程挂起非阻塞它强调没有一个线程可以阻塞其他线程,所有的线程都会尝试地往前运行。

临界区

表示一种公共资源或者说是共享数据,可以被多个线程使用。

但是每个线程使用时,一旦临界区资源被一个线程占有,那么其他线程必须等待。

线程的状态&操作

线程创建

一个java程序从main()方法开始执行,然后按照既定的代码逻辑执行,看似没有其他线程参与,但实际上java程序天生就是一个多线程程序,包含了

- 分发处理发送给给JVM信号的线程

- 调用对象的finalize方法的线程

- 清除Reference的线程

- main线程,用户程序的入口

那么,如何在用户程序中新建一个线程了,只要有三种方式:

- 通过继承Thread类,重写run方法

- 通过实现runable接口

- 通过实现callable接口这三种方式

- 代码示例三种新建线程的方式具体看以上注释,需要主要的是:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53package thread;

import java.util.concurrent.*;

public class test001

{

public static void main(String[] args)

{

//1.继承Thread

Thread thread = new Thread(){

public void run()

{

super.run();

System.out.println("继承Thread");

}

};

thread.start();

//2.实现runable接口

Thread thread1 = new Thread(new Runnable() {

public void run() {

System.out.println("实现runable接口");

}

});

thread1.start();

//3.实现callable接口

ExecutorService executorService= Executors.newSingleThreadExecutor();

Future<String> future=executorService.submit(new Callable<String>()

{

public String call() throws Exception

{

return "通过实现Callable接口";

}

});

try

{

String result=future.get();

System.out.println(result);

} catch (InterruptedException e)

{

e.printStackTrace();

} catch (ExecutionException e)

{

e.printStackTrace();

}

}

} - 由于java不能多继承可以实现多个接口,因此,在创建线程的时候尽量多考虑采用实现接口的形式;

- 实现callable接口,提交给ExecutorService返回的是异步执行的结果,

通常也可以利用FutureTask(Callable callable)将callable进行包装

然后FeatureTask提交给ExecutorsService

另外由于FeatureTask也实现了Runable接口也可以利用上面第二种方式(实现Runable接口)来新建线程;

- 可以通过Executors将Runable转换成Callable,具体方法是:Callable callable(Runnable task, T result), Callable callable(Runnable task)。

1

2

3

4

5

6

7

8

9

10

11

12// 简单创建

FutureTask<String> futureTask=new FutureTask<>(new Callable<String>()

{

public String call() throws Exception

{

System.out.println("FutureTask");

return null;

}

});

Thread thread2=new Thread(futureTask);

thread2.start();

线程生命周期

1 | + 新建(new Thread) |

线程状态

线程的状态,Thread类中枚举类State中的定义

NEW尚未启动的线程所处的状态。

例如:线程对象已经创建了,但还没有调用start()方法RUNNABLE在Java虚拟机中执行的线程所处的状态。

当线程有资格运行,但调度程序还没有把它选定为运行线程时线程所处的状态。

当start()方法调用时,线程首先进入可运行状态,随时可能被CPU调度执行。BLOCKED在等待监视器锁时被阻塞的线程所处的状态。

处于阻塞状态的线程正在等待其他线程释放监视器锁,不能进入同步块/方法WAITING无限期等待另一个线程执行特定操作的线程所处的状态。

例如,对一个对象调用Object.wait()的线程正在等待,另一个线程对该对象调用Object.notify()或Object.notifyAll可以使其唤醒为RUNNABLE状态.

调用了Thread.join()的线程正在等待指定的线程终止,所处的状态。

一个线程由于调用下列方法之一而处于等待状态:- Object.wait()

- Thread.join()

- LockSupport.park()

TIMED_WAITING在指定等待时间内等待另一个线程执行某个操作的线程所处的状态。

线程处于定时等待状态- Thread.sleep(long)

- Object.wait(long)

- Thread.join(long)

- LockSupport.parkNanos(long)

- LockSupport.parkUntil(long)

TERMINATED退出的线程所处的状态。

线程执行完了或因异常退出了run()方法。

关于调度问题:

RUNNABLE随时可能被CPU调度执行;

运行状态是获取CPU权限正在进行执行;

BLOCKED,WAITING,TIMED_WAITING状态是线程因为某种原因放弃CPU使用权,暂时停止运行.直到线程进入RUNNABLE状态,才有机会转到运行状态

- 线程创建之后调用start()方法开始运行

- 调用wait(),join(),LockSupport.lock()进入

等待状态 - 调用wait(long timeout),sleep(long),join(long),LockSupport.parkNanos(),LockSupport.parkUtil()进入

超时等待状态 - 当

超时等待状态时间到达后,线程会切换到运行状态 - 另外

等待状态和超时等待状态时可以通过Object.notify(),Object.notifyAll()方法使线程转换到运行状态 - 当线程出现资源竞争时,即等待获取锁的时候,线程会进入到

阻塞状态 - 当线程获取锁时,线程进入到

运行状态 - 线程运行结束后,线程进入到

终止状态 - 状态转换可以说是线程的生命周期

- 另外需要注意的是

- 当线程进入到synchronized方法或者synchronized代码块时,线程切换到的是

阻塞状态 - 而使用java.util.concurrent.locks下lock进行加锁的时候线程切换的是

等待或者超时等待状态,因为lock会调用LockSupport的方法。

- 当线程进入到synchronized方法或者synchronized代码块时,线程切换到的是

用一个表格将上面六种状态进行一个总结归纳。

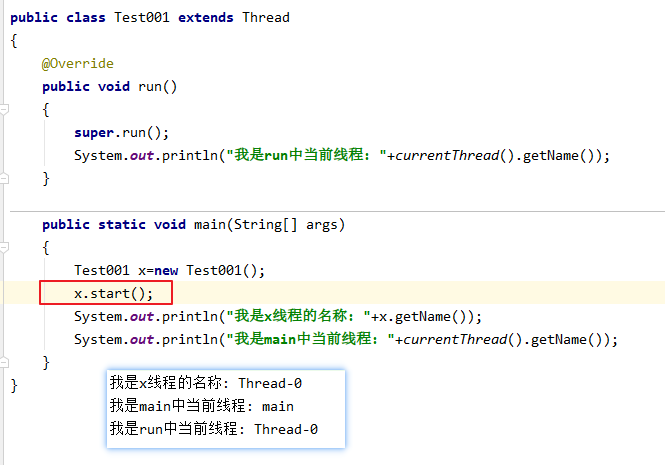

run()和start()

start会开启一个新线程,run不会对象.start();会先执行后面的内容,再执行对象中的run方法对象.run();会先执行对象中的run方法,再执行后面的内容

总结

start是开启一个新的线程,在新线程中执行

run是在主线程中执行该方法,和调普通方法一样

线程状态操作

除了新建一个线程外,线程在生命周期内还有需要基本操作,而这些操作会成为线程间一种通信方式

例如使用中断(interrupted)方式通知实现线程间的交互等等,下面就将具体说说这些操作。

interrupted

1 | // 2022-02-25 20:15:22 再理解 |

1 | 2020-07-06 14:37:25再理解 |

中断可以理解为线程的一个中断状态,它表示了一个运行中的线程是否被其他线程进行了中断操作。

中断好比其他线程对该线程打了一个招呼。

其他线程可以调用该线程的interrupt()方法对其进行中断操作,同时该线程可以调用 isInterrupted()来感知其他线程对其自身的中断操作,从而做出响应。

另外,同样可以调用Thread的静态方法 interrupted()对当前线程进行中断操作,该方法会清除中断状态。

需要注意的是,当抛出InterruptedException时候,会清除中断状态,也就是说在调用isInterrupted会返回false。

Object.interrupt()方法

- 源码

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44/**

* 中断这个线程。

*

* 除非当前线程本身正在中断, 这是允许的,

* 调用该线程的`checkAccess`方法, 这可能导致抛出`SecurityException`异常.

*

* 除非当前线程本身正在中断,否则调用`checkAccess()`方法将抛出`SecurityException`异常.

*

* 如果这个线程已经调用了这个方法,再调用

* `wait()/wait(long)/wait(long, int)`

* `join()/join(long)/join(long, int)`

* `sleep(long)/sleep(long, int)`

* 会清除中断状态,并抛出`InterruptedException`异常

*

* 如果线程在`java.nio.channels.InterruptibleChannel`的I/O操作中被阻塞,

* 这个线程将设置中断状态,并抛出`java.nio.channels.ClosedByInterruptException`异常

*

* 如果这个线程在`java.nio.channels.Selector`中被阻塞,那么这个线程将被设置中断状态,

* 并且它将立即从选择操作返回,可能带有一个非零值,就像调用了选择器(java.nio.channels.Selector)的`wakeup`方法一样。

*

* 如果前面的条件都不成立,那么这个线程的中断状态将被设置。

*

* 中断非活动的线程不一定会有任何影响。

*

* @throws SecurityException

* 如果当前线程不能修改此线程

*

* @revised 6.0

* @spec JSR-51

*/

public void interrupt() {

if (this != Thread.currentThread())

checkAccess();

synchronized (blockerLock) {

Interruptible b = blocker;

if (b != null) {

interrupt0(); // Just to set the interrupt flag

b.interrupt(this);

return;

}

}

interrupt0();

} - 示例代码

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28SimpleDateFormat sdf = new SimpleDateFormat("yyyy-MM-dd HH:mm:ss SSS");

Thread thread = new Thread(() ->

{

try {

System.out.println(1);

if (!Thread.currentThread().isInterrupted())

System.out.println(2);

Thread.sleep(3 * 1000);

} catch (InterruptedException e) {

System.out.println("异常1...");

if (!Thread.currentThread().isInterrupted())

System.out.println(2222);

System.out.println(3);

System.out.println(sdf.format(new Date()));

}

});

System.out.println(sdf.format(new Date()));

thread.start();

try {

System.out.println(4);

Thread.sleep(1000);

System.out.println(5);

} catch (InterruptedException e) {

System.out.println("异常2...");

}

System.out.println(6);

thread.interrupt();

System.out.println(7); - 执行结果

1

2

3

4

5

6

7

8

9

10

112019-11-21 16:18:24 759

4

1

2

5

6

7

异常1...

2222

3

2019-11-21 16:18:25 818 - 分析

开启thread线程,打印4,主线休眠1s,让其他线程执行,这里执行thread线程,打印1,默认中断状态为false,所以打印2,

1秒之后,主线程恢复,打印5,没有异常,再往下走,打印6,把thread线程的中断状态改为true,表示中断,

这时只是进行了设置,此时CPU还在执行主线程,打印7,这时再把CPU给到thread线程,

这时在执行sleep方法,所以会立即异常,并清除中断状态,也就是再设置为false,所以还是会打印2222,再打印3,执行完毕…

整个过程1秒多点儿

Object.isInterrupted()方法

- 源码

1

2

3public boolean isInterrupted() {// false表示`不清除中断状态`

return isInterrupted(false);

}

无论调用多少次都返回true(因为无论调用多少次都不会清除中断状态)

1 | Thread.currentThread().interrupt(); |

Thread.interrupted()方法

- 源码

1

2

3public static boolean interrupted() {// true表示`清除中断状态`

return currentThread().isInterrupted(true);

}

第一次调用返回true,再次调用返回false(因为在第一次调用的时候就已经清除了中断状态)

1 | Thread.currentThread().interrupt(); |

深度理解Object.interrupt()方法

- 代码示例

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47public class ThreadInterrupt {

public static void main(String[] args) {

final SimpleDateFormat format = new SimpleDateFormat("yyyy-MM-dd HH:mm:ss");

Thread thread0 = new Thread(new Runnable() {

public void run() {

while (!Thread.currentThread().isInterrupted()) {

try {

System.out.println(format.format(new Date()) + " " + Thread.currentThread().getName() + " 1");

Thread.sleep(10 * 1000);

System.out.println(format.format(new Date()) + " " + Thread.currentThread().getName() + " 2");

} catch (InterruptedException e) {

System.out.println(format.format(new Date()) + " " + Thread.currentThread().getName() + " 3");

}

}

}

});

Thread thread1 = new Thread(new Runnable() {

public void run() {

while (!Thread.currentThread().isInterrupted()) {

try {

System.out.println(format.format(new Date()) + " " + Thread.currentThread().getName() + " 4");

Thread.sleep(10 * 1000);

System.out.println(format.format(new Date()) + " " + Thread.currentThread().getName() + " 5");

} catch (InterruptedException e) {

System.out.println(format.format(new Date()) + " " + Thread.currentThread().getName() + " 6");

Thread.currentThread().interrupt();

}

}

System.out.println(format.format(new Date()) + " " + Thread.currentThread().getName() + " 7");

}

});

System.out.println(format.format(new Date()) + " " + Thread.currentThread().getName() + " 8");

thread0.start();

thread1.start();

try {

Thread.sleep(2000);

System.out.println(format.format(new Date()) + " " + Thread.currentThread().getName() + " 9");

thread0.interrupt();

thread1.interrupt();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

} - 执行结果

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

162019-11-21 16:34:34 main 8

2019-11-21 16:34:34 Thread-0 1

2019-11-21 16:34:34 Thread-1 4

2019-11-21 16:34:36 main 9

2019-11-21 16:34:36 Thread-1 6

2019-11-21 16:34:36 Thread-0 3

2019-11-21 16:34:36 Thread-1 7

2019-11-21 16:34:36 Thread-0 1

2019-11-21 16:34:46 Thread-0 2

2019-11-21 16:34:46 Thread-0 1

2019-11-21 16:34:56 Thread-0 2

2019-11-21 16:34:56 Thread-0 1

...

会一直循环10秒一次2 1 - 分析

先打印9,再开启两个线程,再让当前线程(main)休眠2s,也就是至少2s之内不可运行,让其他线程获得运行的机会(这里指thread0和thread1两个线程获得运行的机会),

这里执行thread0和执行thread1可以重排序,这里是先执行了thread0线程,打印1,然后睡眠10s,这时再把CPU给其他线程,这时只能执行thread1,打印4,thread1再睡眠10秒,

这时三个都在睡眠,main线程先醒来,就他自己,所以main线程无需竞争,直接获得运行资格继续往下执行,打印9,这时把thread0与thread1设置了中断状态为true,这时主线程也执行完毕了,

又因为他们两个线程都在sleep睡眠,所以,都出现异常,这里thread0的打印3打印1不能重排序,thread1的打印6当前线程(thread1)设置中断状态为true(也就是跳出了thread1的循环)打印7不能重排序,

但是他们两个线程没有先后关系,可以对这两个线程同时进行,交替执行命令,这里打印6,3,7,1 在6与7直接还进行了当前线程(thread1)设置中断状态为true(也就是跳出了thread1的循环),

这时候只有thread0还在循环执行,每过10s就会打印2,1

测试代码

Object.isInterrupted();//Boolean1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23public static void main(String[] args)

{

Thread t = Thread.currentThread();

System.out.println("1: " + t.isInterrupted());

t.interrupt();

System.out.println("2: " + t.isInterrupted());

System.out.println("3: " + t.isInterrupted());

try {

Thread.sleep(2000);

System.out.println("not interrted...");

} catch (InterruptedException e) {

System.out.println("interrupted...");

System.out.println("4: " + t.isInterrupted());

}

System.out.println("5: " + t.isInterrupted());

}

//输出结果

// 1: false

// 2: true

// 3: true

// interrupted...

// 4: false

// 5: false实例代码

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30public class InterruptDemo {

public static void main(String[] args) throws InterruptedException {

//sleepThread睡眠1000ms

final Thread sleepThread = new Thread() {

public void run() {

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

System.out.println("sleepThread抛出异常...");

}

super.run();

}

};

//busyThread一直执行死循环

Thread busyThread = new Thread() {

public void run() {

while (true) ;

}

};

sleepThread.start();

busyThread.start();

sleepThread.interrupt();

busyThread.interrupt();

while (sleepThread.isInterrupted()) ;

System.out.println("sleepThread isInterrupted: " + sleepThread.isInterrupted());

System.out.println("busyThread isInterrupted: " + busyThread.isInterrupted());

}

}输出结果

1

2

3sleepThread isInterrupted: false

busyThread isInterrupted: true

sleepThread抛出异常...

开启了两个线程分别为sleepThread和BusyThread, sleepThread睡眠1s,BusyThread执行死循环。

然后分别对着两个线程进行中断操作,可以看出sleepThread抛出InterruptedException后清除中断状态,而busyThread就不会清除中断状态。

另外,同样可以通过中断的方式实现线程间的简单交互, while (sleepThread.isInterrupted()) 表示在Main中会持续监测sleepThread,一旦sleepThread的中断状态清零,即sleepThread.isInterrupted()返回为false时才会继续Main线程才会继续往下执行。

因此,中断操作可以看做线程间一种简便的交互方式。

一般在结束线程时通过中断状态的方式可以有机会去清理资源,相对于武断而直接的结束线程,这种方式要优雅和安全。

join

- 先来示例

join方法可以看做是线程间协作的一种方式,很多时候,一个线程的输入可能非常依赖于另一个线程的输出

这就像两个好基友,一个基友先走在前面突然看见另一个基友落在后面了,这个时候他就会在原处等一等这个基友,等基友赶上来后,就两人携手并进。

其实线程间的这种协作方式也符合现实生活。在软件开发的过程中,从客户那里获取需求后,需要经过需求分析师进行需求分解后,这个时候产品,开发才会继续跟进。

Object.join()与Object.join(long millis)源码

- Object.join()

1

2

3

4

5

6

7

8

9

10

11/**

* 等待线程死亡。

*

* 此方法的调用与调用`join(0)`完全相同

*

* @throws InterruptedException

* 如果任何线程中断了当前线程。当抛出此异常时,当前线程的“interrupted status中断状态”将被清除。

*/

public final void join() throws InterruptedException {

join(0);

} - Object.join(long millis)

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41/**

* 等待这个线程死亡的时间最多为 millis 毫秒。如果millis=0表示永远等待

*

* 这个实现以`this.isAlive`作为一个条件,循环调用`this.wait`

* 调用`this.notifyAll`使线程终止

* 建议不要在`Thread`实例的应用程序上使用`wait` `notify` `notifyAll`

*

* @param millis

* 等待的时间以毫秒为单位

*

* @throws IllegalArgumentException

* 如果 millis 的值是负数

*

* @throws InterruptedException

* 如果任何线程中断了当前线程。

* 当抛出此异常时,当前线程的“interrupted status中断状态”将被清除。

*/

public final synchronized void join(long millis)

throws InterruptedException {

long base = System.currentTimeMillis();

long now = 0;

if (millis < 0) {

throw new IllegalArgumentException("timeout value is negative");

}

if (millis == 0) {

while (isAlive()) {

wait(0);

}

} else {

while (isAlive()) {

long delay = millis - now;

if (delay <= 0) {

break;

}

wait(delay);

now = System.currentTimeMillis() - base;

}

}

}

join可以控制线程执行顺序

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25//Thread的join的使用

public static void main(String[] args) throws Exception

{

Thread threadA=new Thread(()->{

for (int i = 0; i < 10; i++)

{

System.out.println(Thread.currentThread().getName()+i);

}

},"A");

threadA.start();

/*

加了这一行,当前main线程就会把CPU执行权交给A线程,

只有A线程执行完毕才会把CPU执行权交给main线程,继续往下执行

threadA.join();如果不加这行代码,他们就会随机执行。

*/

threadA.join();

Thread threadB=new Thread(()->{

for (int i = 0; i < 10; i++)

{

System.out.println(Thread.currentThread().getName()+i);

}

},"B");

threadB.start();

}简单示例

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37public static void main(String[] args)

{

Thread t1 = new Thread(() -> System.out.println("t1"));

Thread t2 = new Thread(() ->

{

try

{

// 引用t1线程,等待t1线程执行完

t1.join();

} catch (InterruptedException e)

{

e.printStackTrace();

}

System.out.println("t2");

});

Thread t3 = new Thread(() ->

{

try

{

// 引用t2线程,等待t2线程执行完

t2.join();

} catch (InterruptedException e)

{

e.printStackTrace();

}

System.out.println("t3");

});

//这里三个线程的启动顺序可以任意,大家可以试下!

t3.start();

t2.start();

t1.start();

}

// 执行结果

t1

t2

t3

【一个线程实例A的RUN中执行了threadB.join(),其含义是:当前线程A会等待threadB线程终止后threadA才会继续执行。】

1 | public static void main(String[] args) |

- 输出结果

1

2

3

4

5

6

7

8111

222

333

444

555

我是thread1.run

666

777

关于join方法一共提供如下这些方法:

public final void join() throws InterruptedException {join(0);}public final synchronized void join(long millis) throws InterruptedException{...}public final synchronized void join(long millis, int nanos) throws InterruptedException{...}

Thread类除了提供join()方法外,另外还提供了超时等待的方法。

如果线程threadB在等待的时间内还没有结束的话,threadA会在超时之下一个续执行。

join方法源码关键是:

1 | ... |

可以看出来当前等待对象threadA会一直阻塞,直到被等待对象threadB结束后即isAlive()返回false的时候才会结束while循环,当threadB退出时会调用notifyAll()方法通知所有的等待线程。

- 下面用一个具体的例子来说说join方法的使用:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28public class JoinDemo {

public static void main(String[] args) {

Thread previousThread = Thread.currentThread();

for (int i = 1; i <= 10; i++) {

Thread curThread = new JoinThread(previousThread);

curThread.start();

previousThread = curThread;

}

}

static class JoinThread extends Thread {

private Thread thread;

public JoinThread(Thread thread) {

this.thread = thread;

}

public void run() {

try {

thread.join();

System.out.println(thread.getName() + " terminated.");

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

} - 执行结果在上面的例子中一个创建了10个线程,每个线程都会等待前一个线程结束才会继续运行。

1

2

3

4

5

6

7

8

9

10main terminated.

Thread-0 terminated.

Thread-1 terminated.

Thread-2 terminated.

Thread-3 terminated.

Thread-4 terminated.

Thread-5 terminated.

Thread-6 terminated.

Thread-7 terminated.

Thread-8 terminated.

可以通俗的理解成接力,前一个线程将接力棒传给下一个线程,然后又传给下一个线程……

sleep

public static native void sleep(long millis)方法显然是Thread的静态方法,很显然它是让当前线程按照指定的时间休眠

需要注意的是如果当前线程获得了锁,sleep方法并不会失去锁。

sleep是当前线程休眠,Thread中的静态方法,

Thread.sleep(毫秒数)即让当前运行的线程进入TIMED_WAITING(超时等待)状态,调用完成,当前线程进入休眠状态,直到休眠设置的毫秒数后由系统唤醒。

需要注意的是线程与同步锁没有关系,所以不会存在等待释放同步锁这么一说,它可以随意的嵌入方法代码的任何地方进行调用

sleep()和wait()

sleep方法经常拿来与Object.wait()方法进行比价,这也是面试经常被问的地方。

方法原型分别为:

1 | public final native void wait(long timeout) throws InterruptedException; |

1 | public static native void sleep(long millis) throws InterruptedException; |

相同点

- 都是线程同步时会用到的方法,使当前线程暂停运行,把运行机会交给其它线程。

- 如果任何线程在等待期间被中断都会抛出InterruptedException

- 都是native方法

不同点

所在类不同,wait()是Object类中的实例方法;而sleep()是线程Thread类中的静态方法关键点是对锁的保持不同,wait会释放锁;而sleep()并不释放锁

(wait()方法会释放占有的对象锁,使得该线程进入等待池中,等待下一次获取资源。而sleep()方法只是会让出CPU并不会释放掉对象锁)唤醒方法不完全相同,wait依靠notify或者notifyAll、中断发生、或者到达指定时间来唤醒;而sleep()则是到达指定的时间后被唤醒。

(sleep()方法在休眠时间达到后如果再次获得CPU时间片就会继续执行,而wait()方法必须等待Object.notify/Object.notifyAll通知、中断发生、或者到达指定时间来唤醒,并且再次获得CPU时间片才会继续执行。)使用的位置不同,wait只能用在同步代码块中,而sleep用在任何位置。

(wait()方法必须要在同步方法或者同步块中调用,也就是必须已经获得对象锁,而sleep()方法没有这个限制可以在任何地方种使用。)

wait

1 | //唤醒此对象监视器等待的单个线程,被唤醒线程进入就绪状态,先进先出 |

线程的等待与唤醒为什么在Object中而不在线程Thread中,需要强调的是,这里说的线程等待是指让线程等待在某一个对象的监视器上(用Object.wait()表示)

等待时会释放持有该对象的同步锁,依赖于synchronized关键字使用(否则报监视器状态异常IllegalMonitorStateException)。

同样,线程唤醒也是指唤醒等待在某一个对象监视器上的线程(用Object.notify()表示),也依赖于synchronized关键字。

说白了,线程的等待与唤醒都是基于某一对象的监视器。

- 代码示例

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35public class WaitNotify {

public static void main(String[] args) {

final SimpleDateFormat sdf = new SimpleDateFormat("yyyy-MM-dd HH:mm:ss SSS");

final Object object = new Object();

Thread thread = new Thread(new Runnable() {

public void run() {

System.out.println(sdf.format(new Date()) + " " + Thread.currentThread().getName() + " `Thread-0`线程开始运行...");

// `Thread-0`线程等待`main`线程释放`object`同步锁之前 阻塞在`object`对象的监视器(monitor)上

synchronized (object) {

System.out.println(sdf.format(new Date()) + " " + Thread.currentThread().getName() + " 唤醒`main`线程...");

//唤醒一个在`object`对象监视器上等待的线程,唤醒的顺序是FIFO,这里唤醒`main`线程

object.notify();

System.out.println(sdf.format(new Date()) + " " + Thread.currentThread().getName() + " 已唤醒`main`线程...");

}

}

});

synchronized (object) {

System.out.println(sdf.format(new Date()) + " " + Thread.currentThread().getName() + " `main`线程开始执行...");

thread.start();

try {

// `main`线程休眠2s,为了其他线程能拿到CPU,这里指`Thread-0`

Thread.sleep(2 * 1000);

System.out.println(sdf.format(new Date()) + " " + Thread.currentThread().getName() + " `main`线程wait()...");

// 让`main`线程在`object`对象同步锁上一直等待,并释放`object`同步锁

// 使用`object.notify();`可将`main`线程在同步锁对象`object`上唤醒,使`main`线程继续往下执行

object.wait();

} catch (InterruptedException e) {

}

System.out.println(sdf.format(new Date()) + " " + Thread.currentThread().getName() + " `main`线程继续运行...");

}

}

} - 执行结果看了上面的执行结果,可知

1

2

3

4

5

62019-11-21 10:42:27 932 main `main`线程开始执行...

2019-11-21 10:42:27 933 Thread-0 `Thread-0`线程开始运行...

2019-11-21 10:42:29 933 main `main`线程wait()...

2019-11-21 10:42:29 933 Thread-0 唤醒`main`线程...

2019-11-21 10:42:29 933 Thread-0 已唤醒`main`线程...

2019-11-21 10:42:29 933 main `main`线程继续运行...wait(long timeout)是等待期间如果线程未被唤醒,则等待期间后自动唤醒notify()是唤醒一个等待线程,而notifyAll()是唤醒所有等待的线程

yield

public static native void yield();这是一个静态方法,一旦执行,它会是当前线程让出CPU

但是,需要注意的是,让出的CPU并不是代表当前线程不再运行了,如果在下一次竞争中,又获得了CPU时间片当前线程依然会继续运行。

另外,让出的时间片只会分配给当前线程相同优先级的线程。

- 什么是线程优先级?

现代操作系统基本采用时分的形式调度运行的线程,操作系统会分出一个个时间片,线程会分配到若干时间片,当前时间片用完后就会发生线程调度,并等待这下次分配。

线程分配到的时间多少也就决定了线程使用处理器资源的多少,而线程优先级就是决定线程需要或多或少分配一些处理器资源的线程属性。

在Java程序中,通过一个整型成员变量Priority来控制优先级,优先级的范围从1~10

在构建线程的时候可以通过setPriority(int)方法进行设置,默认优先级为5

优先级高的线程相较于优先级低的线程优先获得处理器时间片。

sleep()和yield()

相同点都是当前线程会交出处理器资源不同点sleep()交出来的时间片其他线程都可以去竞争,也就是说都有机会获得当前线程让出的时间片。而yield()方法只允许与当前线程具有相同优先级的线程能够获得释放出来的CPU时间片。

守护线程Daemon

守护线程是一种特殊的线程,就和它的名字一样,它是系统的守护者,在后台默默地守护一些系统服务,比如垃圾回收线程,JIT线程就可以理解守护线程。

与之对应的就是用户线程,用户线程就可以认为是系统的工作线程,它会完成整个系统的业务操作。

用户线程完全结束后就意味着整个系统的业务任务全部结束了,因此系统就没有对象需要守护的了,守护线程自然而然就会退。

当一个Java应用,只有守护线程的时候,虚拟机就会自然退出。

- Daemon线程的示例

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28public class DaemonDemo {

public static void main(String[] args) {

Thread daemonThread = new Thread(new Runnable() {

public void run() {

while (true) {

try {

System.out.println("i am alive");

Thread.sleep(500);

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

System.out.println("finally block");

}

}

}

});

daemonThread.setDaemon(true);

daemonThread.start();

try {

//确保main线程结束前能给daemonThread能够分到时间片

Thread.sleep(800);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

} - 输出结果上面的例子中daemodThread run方法中是一个while死循环,会一直打印,但是当main线程结束后daemonThread就会退出所以不会出现死循环的情况。

1

2

3i am alive

finally block

i am alive

main线程先睡眠800ms保证daemonThread能够拥有一次时间片的机会,也就是说可以正常执行一次打印“i am alive”操作和一次finally块中”finally block”操作。

紧接着main 线程结束后,daemonThread退出,这个时候只打印了”i am alive”并没有打印finnal块中的。

因此,这里需要注意的是守护线程在退出的时候并不会执行finnaly块中的代码,所以将释放资源等操作不要放在finnaly块中执行,这种操作是不安全的

线程可以通过setDaemon(true)的方法将线程设置为守护线程。

并且需要注意的是设置守护线程要先于start()方法,否则会报

1 | Exception in thread "main" java.lang.IllegalThreadStateException |

这样的异常,但是该线程还是会执行,只不过会当做正常的用户线程执行。

Java内存模型以及happens-before规则

JMM的介绍

在多线程中稍微不注意就会出现线程安全问题,那么什么是线程安全问题?

在<<深入理解Java虚拟机>>中看到的定义。原文如下:当多个线程访问同一个对象时,如果不用考虑这些线程在运行时环境下的调度和交替运行,也不需要进行额外的同步,或者在调用方进行任何其他的协调操作,调用这个对象的行为都可以获取正确的结果,那这个对象是线程安全的。

出现线程安全的问题一般是因为主内存和工作内存数据不一致性和重排序导致的,

而解决线程安全的问题最重要的就是理解这两种问题是怎么来的,

那么,理解它们的核心在于理解java内存模型(JMM)。

在多线程条件下,多个线程肯定会相互协作完成一件事情,一般来说就会涉及到多个线程间相互通信告知彼此的状态以及当前的执行结果等,

另外,为了性能优化,还会涉及到编译器指令重排序和处理器指令重排序。下面会一一来聊聊这些知识。

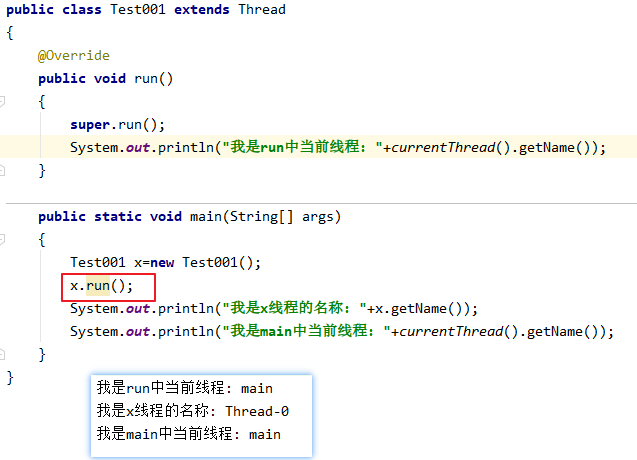

内存模型抽象结构

线程间协作通信可以类比人与人之间的协作的方式,在现实生活中,之前网上有个流行语“你妈喊你回家吃饭了”,

就以这个生活场景为例,小明在外面玩耍,小明妈妈在家里做饭,做晚饭后准备叫小明回家吃饭,那么就存在两种方式:

共享变量

小明妈妈要去上班了十分紧急这个时候手机又没有电了,于是就在桌子上贴了一张纸条“饭做好了,放在…”小明回家后看到纸条如愿吃到妈妈做的饭菜,

那么,如果将小明妈妈和小明作为两个线程,那么这张纸条就是这两个线程间通信的共享变量,通过读写共享变量实现两个线程间协作;线程通信

妈妈的手机还有电,妈妈在赶去坐公交的路上给小明打了个电话,这种方式就是通知机制来完成协作。同样,可以引申到线程间通信机制。

通过上面这个例子,应该有些认识。

在并发编程中主要需要解决两个问题:1. 线程之间如何通信;2.线程之间如何完成同步(这里的线程指的是并发执行的活动实体)。

通信是指线程之间以何种机制来交换信息,主要有两种:共享内存和消息传递。这里,可以分别类比上面的两个举例。

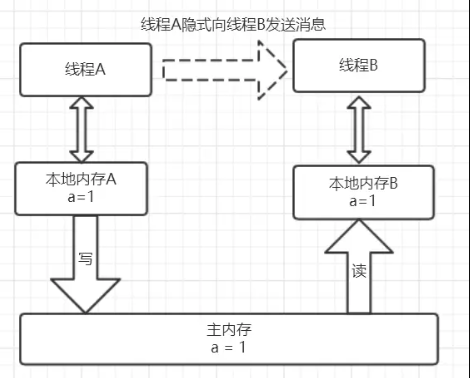

java内存模型是共享内存的并发模型,线程之间主要通过读-写共享变量来完成隐式通信。

如果程序员不能理解Java的共享内存模型在编写并发程序时一定会遇到各种各样关于内存可见性的问题。

哪些是共享变量?

在java程序中所有实例域,静态域,数组元素都是放在堆内存中(所有线程均可访问到,是可以共享的),而局部变量,方法定义参数和异常处理器参数不会在线程间共享

共享数据会出现线程安全的问题,而非共享数据不会出现线程安全的问题。

关于JVM运行时内存区域在后面会讲到。JMM抽象结构模型

我们知道CPU的处理速度和主存的读写速度不是一个量级的,为了平衡这种巨大的差距,每个CPU都会有缓存。

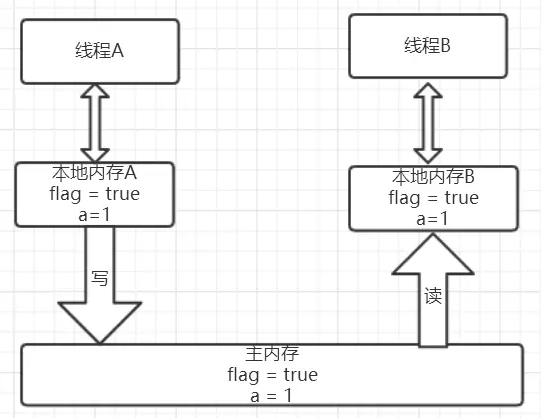

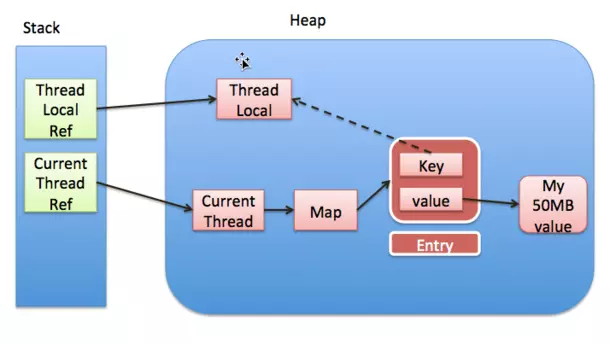

因此,共享变量会先放在主存中,每个线程都有属于自己的工作内存,并且会把位于主存中的共享变量拷贝到自己的工作内存,之后的读写操作均使用位于工作内存的变量副本,并在某个时刻将工作内存的变量副本写回到主存中去。

JMM就从抽象层次定义了这种方式,并且JMM决定了一个线程对共享变量的写入何时对其他线程是可见的。

如图为JMM抽象示意图,线程A和线程B之间要完成通信的话,要经历如下两步:线程A从主内存中将共享变量读入线程A的工作内存后并进行操作,之后将数据重新写回到主内存中;

线程B从主存中读取最新的共享变量

从另一个角度去看,线程A和线程B就好像通过共享变量在进行隐式通信。

这其中有很有意思的问题,如果线程A更新后数据并没有及时写回到主存,而此时线程B读到的是过期的数据,这就出现了“脏读”现象。

可以通过同步机制(控制不同线程间操作发生的相对顺序)来解决或通过volatile关键字使得每次volatile变量都能够强制刷新到主存,从而对每个线程都是可见的。

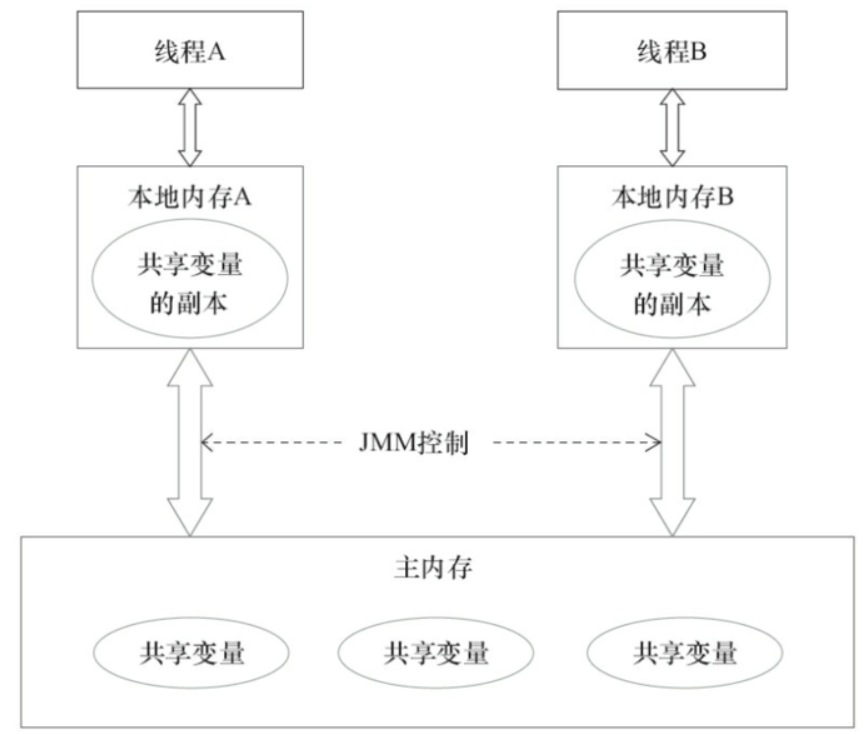

重排序

一个好的内存模型实际上会放松对处理器和编译器规则的束缚,也就是说软件技术和硬件技术都为同一个目标而进行奋斗:在不改变程序执行结果的前提下,尽可能提高并行度。

JMM对底层尽量减少约束,使其能够发挥自身优势。

因此,在执行程序时,为了提高性能,编译器和处理器常常会对指令进行重排序。

一般重排序可以分为如下三种:

编译器优化的重排序编译器在不改变单线程程序语义的前提下,可以重新安排语句的执行顺序;指令级并行的重排序现代处理器采用了指令级并行技术来将多条指令重叠执行。

如果不存在数据依赖性,处理器可以改变语句对应机器指令的执行顺序;内存系统的重排序由于处理器使用缓存和读/写缓冲区,这使得加载和存储操作看上去可能是在乱序执行的。

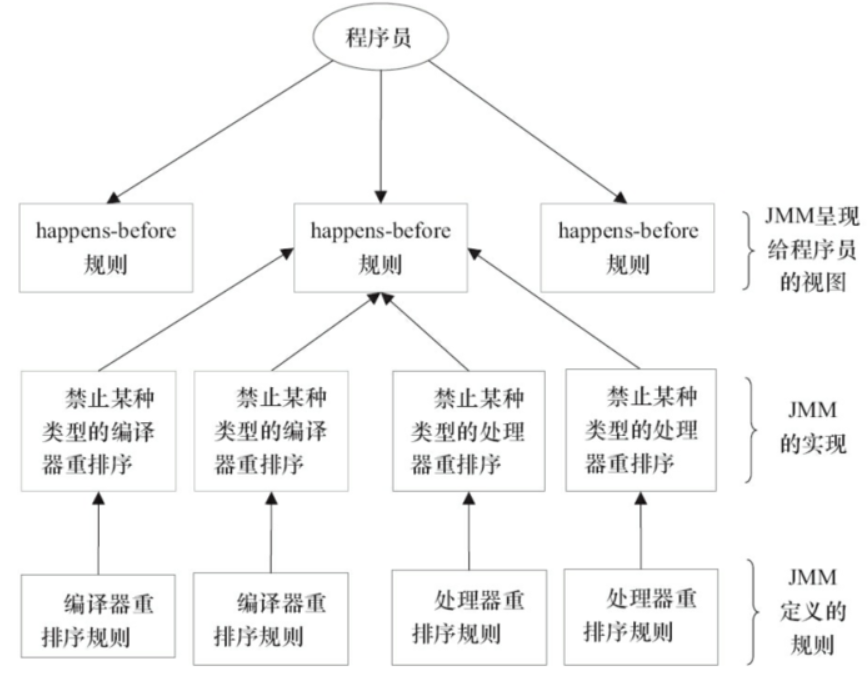

如图,1属于编译器重排序,而2和3统称为处理器重排序。

这些重排序会导致线程安全的问题,一个很经典的例子就是DCL问题,这个在以后的文章中会具体去聊。

针对编译器重排序JMM的编译器重排序规则会禁止一些特定类型的编译器重排序;针对处理器重排序编译器在生成指令序列的时候会通过插入内存屏障指令来禁止某些特殊的处理器重排序。

那么什么情况下,不能进行重排序了?下面就来说说数据依赖性。有如下代码:

1 | double pi = 3.14 //A |

这是一个计算圆面积的代码,由于A,B之间没有任何关系,对最终结果也不会存在关系,它们之间执行顺序可以重排序。

因此可以执行顺序可以是A->B->C或者B->A->C执行最终结果都是3.14,即A和B之间没有数据依赖性。

具体的定义为:如果两个操作访问同一个变量,且这两个操作有一个为写操作,此时这两个操作就存在数据依赖性

这里就存在三种情况:1. 读后写;2.写后写;3. 写后读,者三种操作都是存在数据依赖性的,如果重排序会对最终执行结果会存在影响。

编译器和处理器在重排序时,会遵守数据依赖性,编译器和处理器不会改变存在数据依赖性关系的两个操作的执行顺序

另外,还有一个比较有意思的就是as-if-serial语义。

as-if-serial语义的意思是:不管怎么重排序(编译器和处理器为了提供并行度),(单线程)程序的执行结果不能被改变。

编译器,runtime和处理器都必须遵守as-if-serial语义。

as-if-serial语义把单线程程序保护了起来,遵守as-if-serial语义的编译器,runtime和处理器共同为编写单线程程序的程序员创建了一个幻觉:单线程程序是按程序的顺序来执行的

比如上面计算圆面积的代码,在单线程中,会让人感觉代码是一行一行顺序执行上,实际上A,B两行不存在数据依赖性可能会进行重排序,即A,B不是顺序执行的。

as-if-serial语义使程序员不必担心单线程中重排序的问题干扰他们,也无需担心内存可见性问题。

happens-before

上面的内容讲述了重排序原则,一会是编译器重排序一会是处理器重排序,如果让程序员再去了解这些底层的实现以及具体规则,那么程序员的负担就太重了,严重影响了并发编程的效率。

因此,JMM为程序员在上层提供了六条规则,这样我们就可以根据规则去推论跨线程的内存可见性问题,而不用再去理解底层重排序的规则。

定义

由于这两个操作可以在一个线程之内,也可以是在不同线程之间。

因此,JMM可以通过happens-before关系向程序员提供跨线程的内存可见性保证(如果A线程的写操作a与B线程的读操作b之间存在happens-before关系,尽管a操作和b操作在不同的线程中执行,但JMM向程序员保证a操作将对b操作可见)。

具体的定义为:

- 如果

A操作happens-beforeB操作,那么A操作的执行结果将对B操作可见,而且A操作的执行顺序排在B操作之前。 - 两个操作之间存在happens-before关系,并不意味着Java平台的具体实现必须要按照happens-before关系指定的顺序来执行。

如果重排序之后的执行结果,与按happens-before关系来执行的结果一致,那么这种重排序并不非法(也就是说,JMM允许这种重排序)。

- 上面的1)是JMM对程序员的承诺。

从程序员的角度来说,可以这样理解happens-before关系:如果A happens-before B,那么Java内存模型将向程序员保证——A操作的结果将对B可见,且A的执行顺序排在B之前。注意,这只是Java内存模型向程序员做出的保证! - 上面的2)是JMM对编译器和处理器重排序的约束原则。

正如前面所言,JMM其实是在遵循一个基本原则:只要不改变程序的执行结果(指的是单线程程序和正确同步的多线程程序),编译器和处理器怎么优化都行。

JMM这么做的原因是:程序员对于这两个操作是否真的被重排序并不关心,程序员关心的是程序执行时的语义不能被改变(即执行结果不能被改变)。

因此,happens-before关系本质上和as-if-serial语义是一回事。

比较一下as-if-serial和happens-before:

- as-if-serial语义保证单线程内程序的执行结果不被改变,happens-before关系保证正确同步的多线程程序的执行结果不被改变。

- as-if-serial语义给编写单线程程序的程序员创造了一个幻境:单线程程序是按程序的顺序来执行的。happens-before关系给编写正确同步的多线程程序的程序员创造了一个幻境:正确同步的多线程程序是按happens-before指定的顺序来执行的。

只要结果不改变,就可以进行重排序 - as-if-serial语义和happens-before这么做的目的,都是为了在不改变程序执行结果的前提下,尽可能地提高程序执行的并行度。

规则

程序顺序规则一个线程中的每个操作,happens-before于该线程中的任意后续操作

(一段代码在单线程中执行的结果是有序的。

注意是执行结果,因为虚拟机、处理器会对指令进行重排序。

虽然重排序了,但是并不会影响程序的执行结果,所以程序最终执行的结果与顺序执行的结果是一致的。

故而这个规则只对单线程有效,在多线程环境下无法保证正确性。)监视器锁规则对一个监视器的解锁,happens-before于随后对这个监视器的加锁

(无论是在单线程环境还是多线程环境,一个锁处于被锁定状态,那么必须先执行unlock操作后面才能进行lock操作。)volatile变量规则对一个volatile域的写,happens-before于任意后续对这个volatile的读传递性如果A happens-before B,且B happens-before C,那么A happens-before C。start()线程启动规则Thread对象的start()方法先行发生于此线程的每个一个动作;

(假定线程A在执行过程中,在A的run方法中执行ThreadB.start()来启动线程B,那么线程A对共享变量的修改在接下来线程B开始执行后确保对线程B可见。)join()线程终结规则线程中所有的操作都先行发生于线程的终止检测,我们可以通过Thread.join()方法结束、Thread.isAlive()的返回值手段检测到线程已经终止执行;

(假定线程A在执行的过程中,通过制定ThreadB.join()等待线程B终止,那么线程B在终止之前对共享变量的修改在线程A等待返回后可见。)线程中断规则对线程interrupted()方法的调用先行于被中断线程的代码检测到中断时间的发生。finalize()对象终结规则一个对象的初始化完成(构造函数执行结束)先行于发生它的finalize()方法的开始。示例1

假设线程A执行writer()方法之后,线程B执行reader()方法,1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16class VolatileExample {

int a = 0;

volatile boolean flag = false;

public void writer() {

a = 1; //1

flag = true; //2

}

public void reader() {

if (flag) { //3

int i = a; //4

...

}

}

}

那么线程B执行4的时候一定能看到线程A写入的值吗?注意,a不是volatile变量。

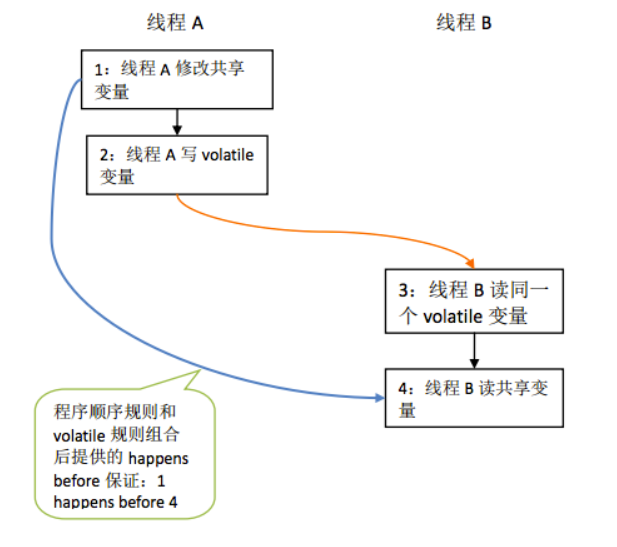

答案是肯定的。因为根据happens-before规则,我们可以得到如下关系:- 根据程序顺序规则,1 happens-before 2;3 happens-before 4。

- 根据volatile规则,2 happens-before 3。

- 根据传递性规则,1 happens-before 4。

因此,综合运用程序顺序规则、volatile规则及传递性规则,我们可以得到1 happens-before 4,即线程B在执行4的时候一定能看到A写入的值。

上述关系图示如下:

示例2

1 | class MonitorExample { |

假设线程A执行writer()方法之后,线程B执行reader()方法。

那么根据happens-before规则,我们可以得到:

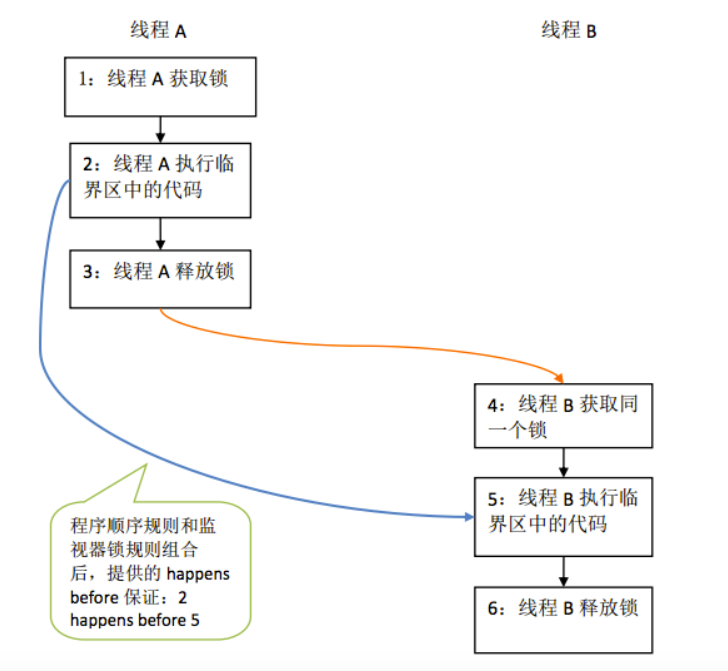

- 根据程序顺序规则,1 happens-before 2,2 happens-before 3;4 happens-before 5,5 happens-before 6。

- 根据监视器锁规则,3 happens-before 4。

- 根据传递性规则,2 happens-before 5。

上述关系图示如下:

示例3

1 | int a = 3; //1 |

这里//2对b赋值的操作会用到变量a,那么java的“单线程happen-before原则”就保证//2的中的a的值一定是3,而不是0,5,等其他乱七八糟的值,因为//1书写在//2前面,//1对变量a的赋值操作对//2一定可见。

因为//2中有用到//1中的变量a,再加上java内存模型提供了“单线程happen-before原则”,所以java虚拟机不许可操作系统对//1 //2操作进行指令重排序,即不可能有//2在//1之前发生。

但是对于下面的代码:两个语句直接没有依赖关系,所以指令重排序可能发生,即对b的赋值可能先于对a的赋值。

1 | int a = 3; |

示例4

1 | public class A { |

1 | //线程1执行的代码: |

1 | //线程2执行的代码: |

1 | //线程3执行的代码: |

如果某个时刻执行完“线程1” 马上执行“线程2”,因为“线程1”执行A类的method1方法后肯定要释放锁,“线程2”在执行A类的method2方法前要先拿到锁,符合“锁的happen-before原则”,那么在“线程2”method2方法中的变量var一定是3,所以变量b的值也一定是3。

但是如果是“线程1”、“线程3”、“线程2”这个顺序,那么最后“线程2”method2方法中的b值是3,还是4呢?其结果是可能是3,也可能是4。

的确“线程3”在执行完method3方法后的确要unlock,然后“线程2”有个lock,但是这两个线程用的不是同一个锁,所以JMM这个两个操作之间不符合八大happen-before中的任何一条,所以JMM不能保证“线程3”对var变量的修改对“线程2”一定可见,虽然“线程3”先于“线程2”发生。

示例5

1 | volatile int a; |

1 | a = 1; //1 |

1 | b = a; //2 |

如果线程1 执行//1,“线程2”执行了//2,并且“线程1”执行后,“线程2”再执行,那么符合“volatile的happen-before原则”所以“线程2”中的a值一定是1。

总结

上面已经聊了关于JMM的两个方面:

- JMM的抽象结构(主内存和线程工作内存);

- 重排序以及happens-before规则。

接下来,我们来做一个总结。从多个方面进行考虑。

- 如果让我们设计JMM应该从哪些方面考虑,也就是说JMM承担哪些功能;

- happens-before与JMM的关系;

- 由于JMM,多线程情况下可能会出现哪些问题?

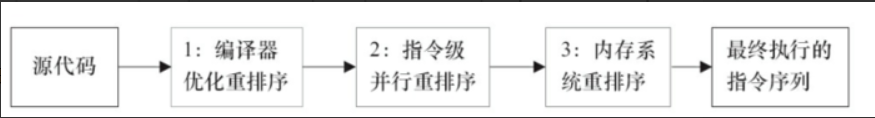

JMM的设计

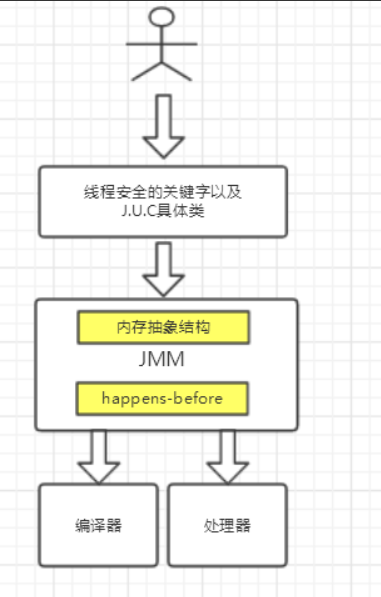

JMM是语言级的内存模型,在我的理解中JMM处于中间层,包含了两个方面:(1)内存模型;(2)重排序以及happens-before规则。

同时,为了禁止特定类型的重排序会对编译器和处理器指令序列加以控制。

而上层会有基于JMM的关键字和J.U.C包下的一些具体类用来方便程序员能够迅速高效率的进行并发编程。

站在JMM设计者的角度,在设计JMM时需要考虑两个关键因素:

程序员对内存模型的使用程序员希望内存模型易于理解、易于编程。程序员希望基于一个强内存模型来编写代码。编译器和处理器对内存模型的实现编译器和处理器希望内存模型对它们的束缚越少越好,这样它们就可以做尽可能多的优化来提高性能。编译器和处理器希望实现一个弱内存模型。

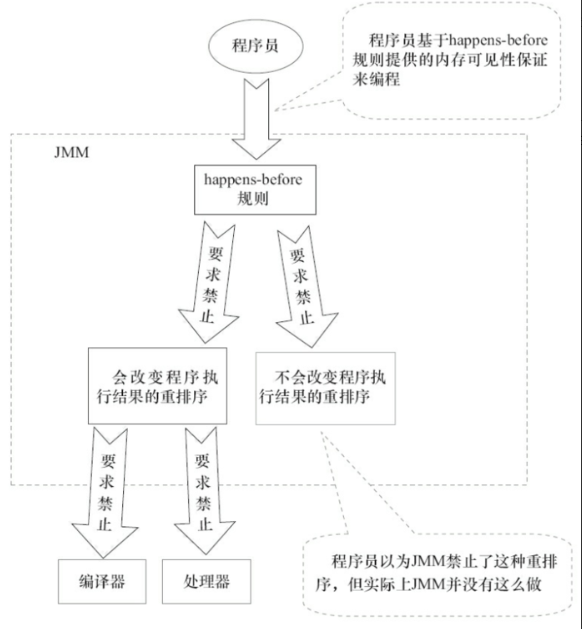

另外还要一个特别有意思的事情就是关于重排序问题

更简单的说,重排序可以分为两类:

- 会改变程序执行结果的重排序。

- 不会改变程序执行结果的重排序。

JMM对这两种不同性质的重排序,采取了不同的策略,如下。

- 对于会改变程序执行结果的重排序,JMM要求编译器和处理器必须禁止这种重排序。

- 对于不会改变程序执行结果的重排序,JMM对编译器和处理器不做要求(JMM允许这种 重排序)

JMM的设计图为:

从图可以看出:

- JMM向程序员提供的happens-before规则能满足程序员的需求。

JMM的happens-before规则不但简单易懂,而且也向程序员提供了足够强的内存可见性保证

(有些内存可见性保证其实并不一定真实存在,例如下面的的A happens-before B)。1

2

3double pi = 3.14 //A

double r = 1.0 //B

double area = pi * r * r //C - JMM对编译器和处理器的束缚已经尽可能少。从上面的分析可以看出,JMM其实是在遵循一个基本原则:

只要不改变程序的执行结果(指的是单线程程序和正确同步的多线程程序),编译器和处理器怎么优化都行。

例如,如果编译器经过细致的分析后,认定一个锁只会被单个线程访问,那么这个锁可以被消除。

再如,如果编译器经过细致的分析后,认定一个volatile变量只会被单个线程访问,那么编译器可以把这个volatile变量当作一个普通变量来对待。

这些优化既不会改变程序的执行结果,又能提高程序的执行效率。

happens-before与JMM的关系

一个happens-before规则对应于一个或多个编译器和处理器重排序规则。

对于Java程序员来说,happens-before规则简单易懂,它避免Java程序员为了理解JMM提供的内存可见性保证而去学习复杂的重排序规则以及这些规则的具体实现方法

今后可能需要关注的问题

从上面内存抽象结构来说,可能出在数据“脏读”的现象,这就是数据可见性的问题,

另外,重排序在多线程中不注意的话也容易存在一些问题,比如一个很经典的问题就是DCL(双重检验锁),这就是需要禁止重排序,

另外,在多线程下原子操作例如i++不加以注意的也容易出现线程安全的问题。

但总的来说,在多线程开发时需要从原子性,有序性,可见性三个方面进行考虑。

J.U.C包下的并发工具类和并发容器也是需要花时间去掌握的,这些东西在以后得文章中多会一一进行讨论。

彻底理解synchronized

synchronized简介

在学习知识前,我们先来看一个现象:

- 示例代码开启了10个线程,每个线程都累加了1,000,000次,如果结果正确的话自然而然总数就应该是

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22public class SynchronizedDemo implements Runnable {

private static int count = 0;

public static void main(String[] args) {

for (int i = 0; i < 10; i++) {

Thread thread = new Thread(new SynchronizedDemo());

thread.start();

}

try {

Thread.sleep(500);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("result: " + count);

}

public void run() {

for (int i = 0; i < 1000000; i++)

count++;

}

}10 * 1,000,000 = 10,000,000。

可就运行多次结果都不是这个数,而且每次运行结果都不一样。这是为什么了?有什么解决方案了?这就是我们今天要聊的事情。

在之前的学习中我们知道了java内存模型的一些知识,并且已经知道出现线程安全的主要来源于JMM的设计,主要集中在主内存和线程的工作内存而导致的内存可见性问题,以及重排序导致的问题,进一步知道了happens-before规则。

线程运行时拥有自己的栈空间,会在自己的栈空间运行,如果多线程间没有共享的数据也就是说多线程间并没有协作完成一件事情,那么,多线程就不能发挥优势,不能带来巨大的价值。

那么共享数据的线程安全问题怎样处理?很自然而然的想法就是每一个线程依次去读写这个共享变量,这样就不会有任何数据安全的问题,因为每个线程所操作的都是当前最新的版本数据。

那么,在java关键字synchronized就具有使每个线程依次排队操作共享变量的功能。

很显然,这种同步机制效率很低,但synchronized是其他并发容器实现的基础,对它的理解也会大大提升对并发编程的感觉,从功利的角度来说,这也是面试高频的考点。

好了,下面,就来具体说说这个关键字。

synchronized实现原理

在java代码中使用synchronized可是使用在代码块和方法中,根据Synchronized用的位置可以有这些使用场景:

如图,synchronized可以用在方法上也可以使用在代码块中,其中方法是实例方法和静态方法分别锁的是该类的实例对象和该类的对象。

而使用在代码块中也可以分为三种,具体的可以看上面的表格。

这里的需要注意的是:如果锁的是类对象的话,尽管new多个实例对象,但他们仍然是属于同一个类依然会被锁住,即线程之间保证同步关系。

现在我们已经知道了怎样synchronized了,看起来很简单,拥有了这个关键字就真的可以在并发编程中得心应手了吗?爱学的你,就真的不想知道synchronized底层是怎样实现了吗?

对象锁(monitor)机制

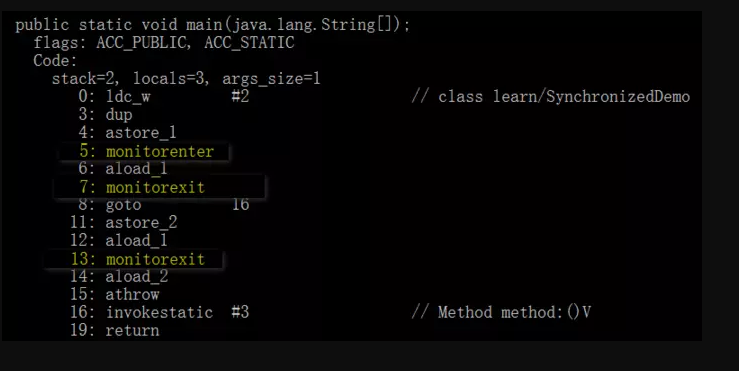

现在我们来看看synchronized的具体底层实现。先写一个简单的demo:

1 | public class SynchronizedDemo { |

上面的代码中有一个同步代码块,锁住的是类对象,并且还有一个同步静态方法,锁住的依然是该类的类对象。

编译之后,切换到SynchronizedDemo.class的同级目录之后,然后用javap -v SynchronizedDemo.class查看字节码文件:

如图,上面用黄色高亮的部分就是需要注意的部分了,这也是添Synchronized关键字之后独有的。

执行同步代码块后首先要先执行monitorenter指令,退出的时候monitorexit指令。

通过分析之后可以看出,使用Synchronized进行同步,其关键就是必须要对对象的监视器monitor进行获取,当线程获取monitor后才能继续往下执行,否则就只能等待。

而这个获取的过程是互斥的,即同一时刻只有一个线程能够获取到monitor。

上面的demo中在执行完同步代码块之后紧接着再会去执行一个静态同步方法,而这个方法锁的对象依然就这个类对象,那么这个正在执行的线程还需要获取该锁吗?

答案是不必的,从上图中就可以看出来,执行静态同步方法的时候就只有一条monitorexit指令,并没有monitorenter获取锁的指令。

这就是锁的重入性,即在同一线程中,线程不需要再次获取同一把锁。

Synchronized先天具有重入性。每个对象拥有一个计数器,当线程获取该对象锁后,计数器就会加一,释放锁后就会将计数器减一。

任意一个对象都拥有自己的监视器,当这个对象由同步块或者这个对象的同步方法调用时,执行方法的线程必须先获取该对象的监视器才能进入同步块和同步方法,

如果没有获取到监视器的线程将会被阻塞在同步块和同步方法的入口处,进入到BLOCKED阻塞状态(关于之前我们讲到的线程的状态转换以及基本操作)

任意线程对Object的访问,首先要获得Object的监视器,如果获取失败,该线程就进入同步状态,线程状态变为BLOCKED阻塞状态,

当Object的监视器占有者释放后,在同步队列中得线程就会有机会重新获取该监视器。

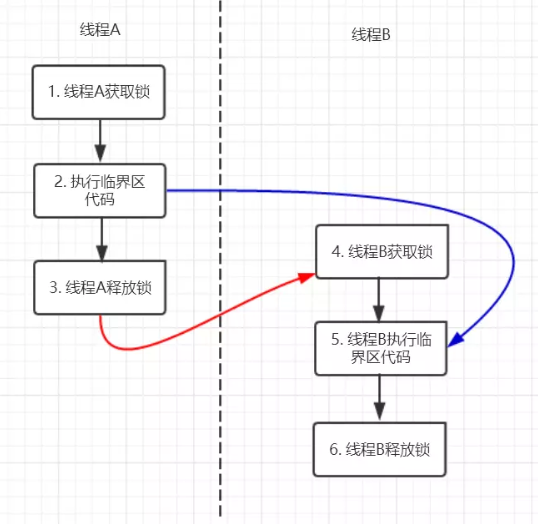

synchronized的happens-before关系

在之前我们讲到happens-before规则,抱着学以致用的原则我们现在来看一看Synchronized的happens-before规则

即监视器锁规则:对同一个监视器的解锁,happens-before于对该监视器的加锁。

- 示例代码该代码的happens-before关系如图所示:

1

2

3

4

5

6

7

8

9

10

11public class MonitorDemo {

private int a = 0;

public synchronized void writer() { // 1

a++; // 2

} // 3

public synchronized void reader() { // 4

int i = a; // 5

} // 6

}

在图中每一个箭头连接的两个节点就代表之间的happens-before关系黑色的是通过程序顺序规则推导出来红色的为监视器锁规则推导而出:线程A释放锁happens-before线程B加锁蓝色的则是通过程序顺序规则和监视器锁规则推测出来happens-befor关系,通过传递性规则进一步推导的happens-before关系

现在我们来重点关注2 happens-before 5,通过这个关系我们可以得出什么?

- 根据happens-before的定义中的一条:如果A happens-before B,则A的执行结果对B可见,并且A的执行顺序先于B。

线程A先对共享变量A进行加一,由2 happens-before 5关系可知线程A的执行结果对线程B可见即线程B所读取到的a的值为1。

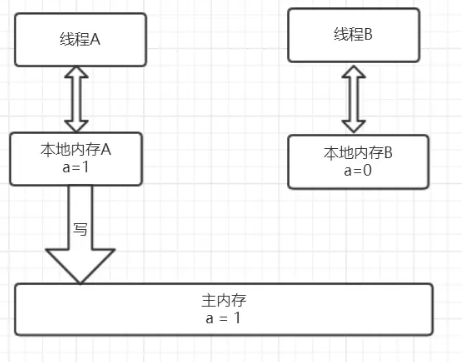

锁获取和锁释放的内存语义

我们先来看看基于java内存抽象模型的Synchronized的内存语义。

从上图可以看出,线程A会首先先从主内存中读取共享变量a=0的值然后将该变量拷贝到自己的本地内存,进行加一操作后,再将该值刷新到主内存,

整个过程即为线程A 加锁–>执行临界区代码–>释放锁相对应的内存语义。

线程B获取锁的时候同样会从主内存中共享变量a的值,这个时候就是最新的值1,然后将该值拷贝到线程B的工作内存中去,释放锁的时候同样会重写到主内存中。

从整体上来看,线程A的执行结果(a=1)对线程B是可见的,

实现原理为:

解释1:释放锁的时候会将值刷新到主内存中,其他线程获取锁时会强制从主内存中获取最新的值。

解释2:先获得锁→清空工作内存→在主内存中拷贝最新变量的副本到工作内存→执行完代码→将更改后的共享变量的值刷新到主内存中→释放锁。

另外也验证了2 happens-before 5,2的执行结果对5是可见的。

从另外一个角度来看,这就像线程A通过主内存中的共享变量和线程B进行通信,A 告诉 B 我们俩的共享数据现在为1啦,

这种线程间的通信机制正好吻合java的内存模型正好是共享内存的并发模型结构。

synchronized优化

通过上面的讨论现在我们对Synchronized应该有所印象了,它最大的特征就是在同一时刻只有一个线程能够获得对象的监视器(monitor),从而进入到同步代码块或者同步方法之中,即表现为互斥性(排它性)。

这种方式肯定效率低下,每次只能通过一个线程,既然每次只能通过一个,这种形式不能改变的话,那么我们能不能让每次通过的速度变快一点了。打个比方,去收银台付款,之前的方式是,大家都去排队,然后去纸币付款收银员找零,有的时候付款的时候在包里拿出钱包再去拿出钱,这个过程是比较耗时的,然后,支付宝解放了大家去钱包找钱的过程,现在只需要扫描下就可以完成付款了,也省去了收银员跟你找零的时间的了。

同样是需要排队,但整个付款的时间大大缩短,是不是整体的效率变高速率变快了?这种优化方式同样可以引申到锁优化上,缩短获取锁的时间

在聊到锁的优化也就是锁的几种状态前,有两个知识点需要先关注:(1)CAS操作 (2)Java对象头,这是理解下面知识的前提条件。

CAS操作

什么是CAS?

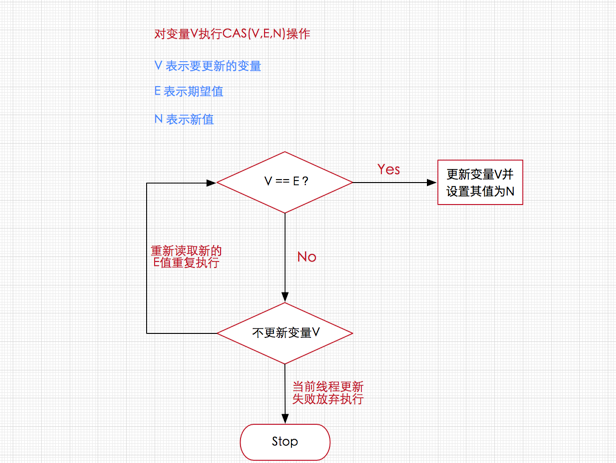

加锁是一种悲观的策略,它总是认为每次访问共享资源的时候,总会发生冲突,所以宁愿牺牲性能(时间)来保证数据安全。无锁是一种乐观的策略,它假设线程访问共享资源不会发生冲突,所以不需要加锁,因此线程将不断执行,不需要停止。一旦碰到冲突,就重试当前操作直到没有冲突为止。

无锁的策略使用一种叫做比较交换的技术(CAS Compare And Swap)来鉴别线程冲突,一旦检测到冲突产生,就重试当前操作直到没有冲突为止。

CAS的实现需要硬件指令集的支撑,在JDK1.5后虚拟机才可以使用处理器提供的CMPXCHG指令实现。

悲观锁&乐观锁

简介

悲观锁(Pessimistic Lock):

每次获取数据的时候,都会担心数据被修改,所以每次获取数据的时候都会进行加锁,确保在自己使用的过程中数据不会被别人修改,使用完成后进行数据解锁。由于数据进行加锁,期间对该数据进行读写的其他线程都会进行等待。

乐观锁(Optimistic Lock):

每次获取数据的时候,都不会担心数据被修改,所以每次获取数据的时候都不会进行加锁,但是在更新数据的时候需要判断该数据是否被别人修改过。如果数据被其他线程修改,则不进行数据更新,如果数据没有被其他线程修改,则进行数据更新。由于数据没有进行加锁,期间该数据可以被其他线程进行读写操作。

适用场景:

悲观锁:比较适合写入操作比较频繁的场景,如果出现大量的读取操作,每次读取的时候都会进行加锁,这样会增加大量的锁的开销,降低了系统的吞吐量。

乐观锁:比较适合读取操作比较频繁的场景,如果出现大量的写入操作,数据发生冲突的可能性就会增大,为了保证数据的一致性,应用层需要不断的重新获取数据,这样会增加大量的查询操作,降低了系统的吞吐量。

总结:两种所各有优缺点,读取频繁使用乐观锁,写入频繁使用悲观锁。

CAS如何鉴别冲突

CAS核心算法:执行函数:CAS(V,E,N)

1 | V表示准备要被更新的变量 |

算法思路:V是共享变量,我们拿着自己准备的这个E,去跟V去比较,

如果E == V ,说明当前没有其它线程在操作,所以,我们把N 这个值 写入对象的 V 变量中。

如果 E != V ,说明我们准备的这个E,已经过时了,所以我们要重新准备一个最新的E ,去跟V 比较,比较成功后才能更新 V的值为N。

CAS的效果

如果多个线程同时使用CAS操作一个变量的时候,只有一个线程能够修改成功。其余的线程提供的期望值已经与共享变量的值不一样了,所以均会失败。

由于CAS操作属于乐观派,它总是认为自己能够操作成功,所以操作失败的线程将会再次发起操作,而不是被OS(Operating System 操作系统)挂起。

所以说,即使CAS操作没有使用同步锁,其它线程也能够知道对共享变量的影响。

因为其它线程没有被挂起,并且将会再次发起修改尝试,所以无锁操作即CAS操作天生免疫死锁。

另外一点需要知道的是,CAS是系统原语,CAS操作是一条CPU的原子指令,所以不会有线程安全问题。

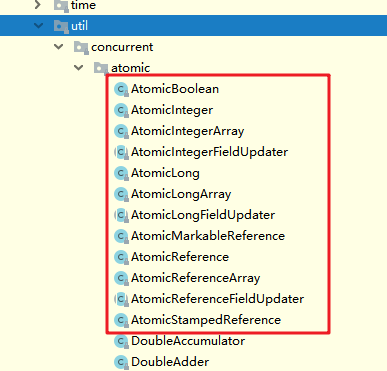

Java提供的CAS操作:原子操作类

Java提供了一个Unsafe类,其内部方法操作可以像指针一样直接操作内存,方法都是native的。

为了让Java程序员能够受益于CAS等CPU指令,JDK并发包中有一个atomic包,它们是原子操作类,它们使用的是无锁的CAS操作,并且统统线程安全。

atomic包下的几乎所有的类都使用了这个Unsafe类。

- atomic包

- 分类如下

这些类中,最有代表性的就是AtomicInteger类。

AtomicInteger类源码,省略了部分代码

1 | public class AtomicInteger extends Number implements java.io.Serializable { |

查看指针类unsafe类的incrementAndGet方法的代码实现,颇具教学意义。

这个方法是一个死循环,不断尝试获取最新的值,也就不断获取 CAS(V,E,N)中的E,也就是我们要提供的期望的值。

如果此时 共享变量V 与 我们的 E 相同,那么就把 V 的值 修改成 N。

下面代码中,先不断尝试获取最新的共享变量的值V,如果其它线程也在同时获取V,并且其它线程抢先将共享变量V 修改成了 V+1,

那么此时,当前线程持有的共享变量的值是V,它去与实际的共享变量值V+1比较,将会比较失败,所以本次自增失败。

但是因为是一个死循环,当前线程将会重新调用 get()方法获取最新的值,直到在其它线程执行CAS操作之前,抢先执行自增共享变量的操作。

1 | public final int incrementAndGet(){ |

ABA问题及其解决方案

在CAS的核心算法中,通过死循环不断获取最新的E。

如果在此之间,V被修改了两次,但是最终值还是修改成了旧值V,这个时候,就不好判断这个共享变量是否已经被修改过。

为了防止这种不当写入导致的不确定问题,原子操作类提供了一个带有时间戳的原子操作类。

带有时间戳的原子操作类AtomicStampedReference (音:a tommy k,S dan P de,Reference)

CAS(V,E,N)

当带有时间戳的原子操作类AtomicStampedReference对应的数值被修改时,除了更新数据本身外,还必须要更新时间戳。

当AtomicStampedReference设置对象值时,对象值以及时间戳都必须满足期望值,写入才会成功。

因此,即使对象值被反复读写,写回原值,只要时间戳发生变化,就能防止不恰当的写入。

Synchronized VS CAS

两者主要的区别。

元老级的Synchronized(未优化前)最主要的问题是:在存在线程竞争的情况下会出现线程阻塞和唤醒锁带来的性能问题,因为这是一种互斥同步(阻塞同步)。

而CAS并不是直接将线程挂起,当CAS操作失败后会进行一定的尝试,而非进行耗时的挂起唤醒的操作,因此也叫做非阻塞同步。

CAS的应用场景

在J.U.C包中利用CAS实现类有很多,可以说是支撑起整个concurrency包的实现,在Lock实现中会有CAS改变state变量,在atomic包中的实现类也几乎都是用CAS实现,

关于这些具体的实现场景在之后会详细聊聊,现在有个印象就好了。

CAS的问题

ABA问题

因为CAS会检查旧值有没有变化,这里存在这样一个有意思的问题。

比如一个旧值A变为了成B,然后再变成A,刚好在做CAS时检查发现旧值并没有变化依然为A,但是实际上的确发生了变化。

解决方案可以沿袭数据库中常用的乐观锁方式,添加一个版本号可以解决。原来的变化路径A->B->A就变成了1A->2B->3C。

java这么优秀的语言,当然在java 1.5后的atomic包中提供了AtomicStampedReference来解决ABA问题,解决思路就是这样的。参考上面提到的.自旋时间过长

使用CAS时非阻塞同步,也就是说不会将线程挂起,会自旋(无非就是一个死循环)进行下一次尝试,如果这里自旋时间过长对性能是很大的消耗。

如果JVM能支持处理器提供的pause(暂停)指令,那么在效率上会有一定的提升。只能保证一个共享变量的原子操作

当对一个共享变量执行操作时CAS能保证其原子性,如果对多个共享变量进行操作,CAS就不能保证其原子性。

有一个解决方案是利用对象整合多个共享变量,即一个类中的成员变量就是这几个共享变量。然后将这个对象做CAS操作就可以保证其原子性。

atomic中提供了AtomicReference来保证引用对象之间的原子性。参考上面提到的.

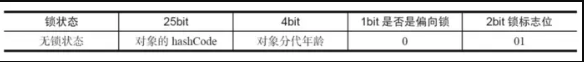

Java对象头

在同步的时候是获取对象的monitor,即获取到对象的锁。

那么对象的锁怎么理解?无非就是类似对对象的一个标志,那么这个标志就是存放在Java对象的对象头。

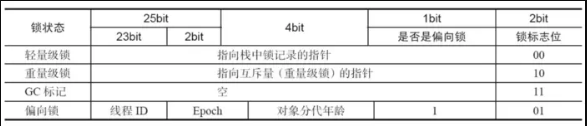

Java对象头里的Mark Word里默认的存放的对象的Hashcode,分代年龄和锁标记位。

32位JVM Mark Word默认存储结构为

如图在Mark Word会默认存放hasdcode,年龄值以及锁标志位等信息。

Java SE 1.6中,锁一共有4种状态,级别从低到高依次是:无锁状态 偏向锁状态 轻量级锁状态 重量级锁状态。

这几个状态会随着竞争情况逐渐升级,锁可以升级但不能降级,意味着偏向锁升级成轻量级锁后不能降级成偏向锁。

这种锁升级却不能降级的策略,目的是为了提高获得锁和释放锁的效率。

对象的MarkWord变化为下图:

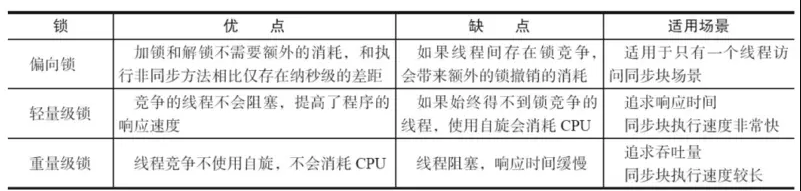

偏向锁

大多数情况下,锁不仅不存在多线程竞争,而且总是由同一线程多次获得,为了让线程获得锁的代价更低而引入了偏向锁。偏向锁(01):一段同步代码只能被一个线程访问,不存在竞争.

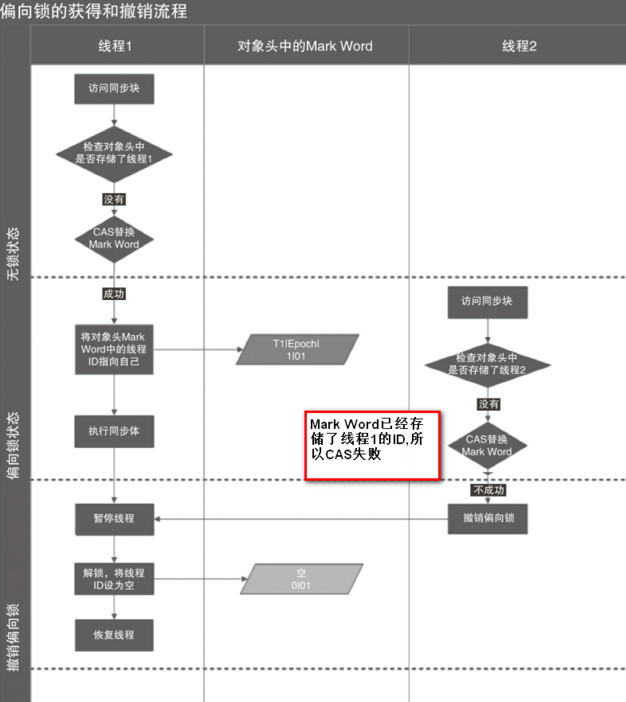

偏向锁的获取

当一个线程访问同步块并获取锁时,会在对象头和栈帧中的锁记录里存储锁偏向的线程ID,

以后该线程在进入和退出同步块时不需要进行CAS操作来加锁和解锁,只需简单地测试一下对象头的Mark Word里是否存储着指向当前线程的偏向锁。

如果测试成功,表示线程已经获得了锁。

如果测试失败,则需要再测试一下Mark Word中偏向锁的标识是否设置成1(表示当前是偏向锁):如果没有设置,则使用CAS竞争锁;如果设置了,则尝试使用CAS将对象头的偏向锁指向当前线程

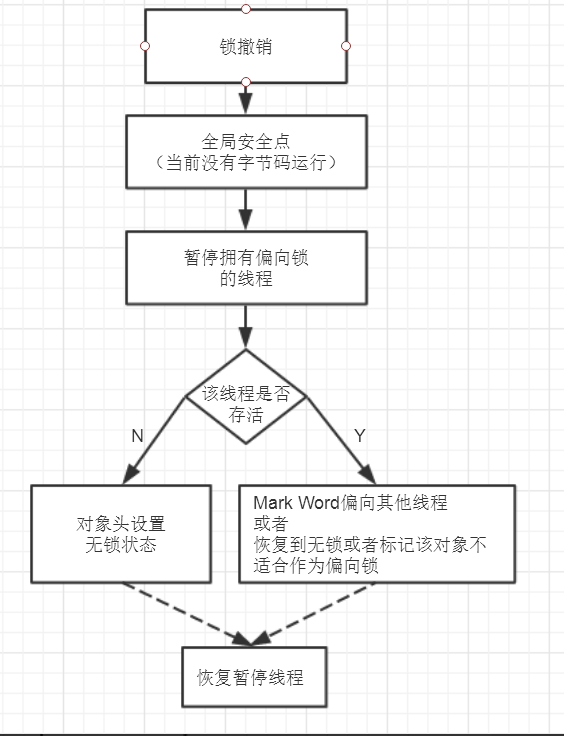

偏向锁的撤销

偏向锁使用了一种等到竞争出现才释放锁的机制,所以当其他线程尝试竞争偏向锁时,持有偏向锁的线程才会释放锁。

如图,偏向锁的撤销,需要等待全局安全点(在这个时间点上没有正在执行的字节码)。

它会首先暂停拥有偏向锁的线程,然后检查持有偏向锁的线程是否活着,

如果线程不处于活动状态,则将对象头设置成无锁状态;

如果线程仍然活着,拥有偏向锁的栈会被执行,遍历偏向对象的锁记录,栈中的锁记录和对象头的Mark Word要么重新偏向于其他线程,要么恢复到无锁或者标记对象不适合作为偏向锁,最后唤醒暂停的线程。

下图线程1展示了偏向锁获取的过程,线程2展示了偏向锁撤销的过程。

如何关闭偏向锁

偏向锁在Java 6和Java 7里是默认启用的,但是它在应用程序启动几秒钟之后才激活,如有必要可以使用JVM参数来关闭延迟:-XX:BiasedLockingStartupDelay=0。

如果你确定应用程序里所有的锁通常情况下处于竞争状态,可以通过JVM参数关闭偏向锁:-XX:-UseBiasedLocking=false,那么程序默认会进入轻量级锁状态

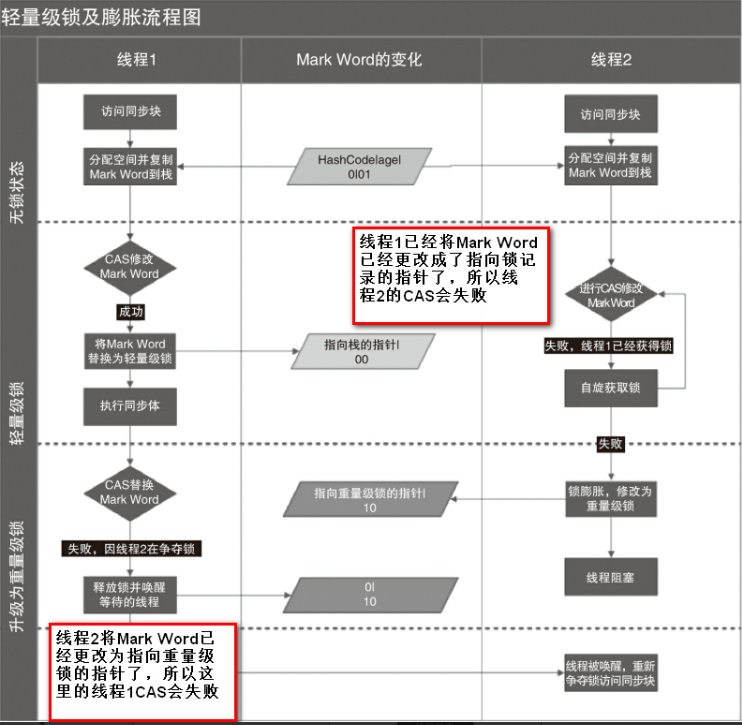

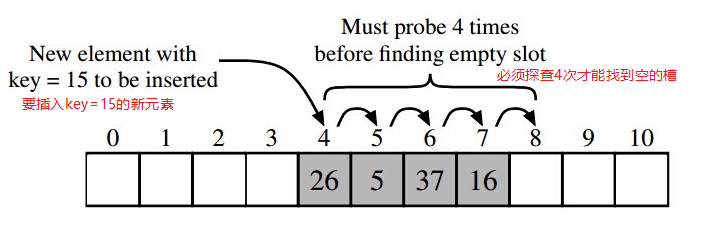

轻量级锁

轻量级锁(00):当锁是偏向锁的时候,被其他线程访问了,这时偏向锁就升级为轻量级锁.其他线程会不断自旋获取锁,不会阻塞,从而提高性能.

加锁

线程在执行同步块之前,JVM会先在当前线程的栈桢中创建用于存储锁记录的空间,并将对象头中的Mark Word复制到锁记录中,官方称为Displaced Mark Word。

然后线程尝试使用CAS将对象头中的Mark Word替换为指向锁记录的指针。

如果成功,当前线程获得锁,

如果失败,表示其他线程竞争锁,当前线程便尝试使用自旋来获取锁。

解锁

轻量级解锁时,会使用原子的CAS操作将Displaced Mark Word替换回到对象头,

如果成功,则表示没有竞争发生。

如果失败,表示当前锁存在竞争,锁就会膨胀成重量级锁。

下图是两个线程同时争夺锁,导致锁膨胀的流程图。

因为自旋会消耗CPU,为了避免无用的自旋(比如获得锁的线程被阻塞住了),一旦锁升级成重量级锁,就不会再恢复到轻量级锁状态。

当锁处于这个状态下,其他线程试图获取锁时,都会被阻塞住,当持有锁的线程释放锁之后会唤醒这些线程,被唤醒的线程就会进行新一轮的夺锁之争。

重量级锁

重量级锁(10):当只有一个等待线程,则该线程自旋等待.但自旋到一定的次数,或一个等待,一个持有锁,当第三个过来时,轻量就会变为重量级锁.一个获取锁,其他线程进行阻塞,而不是自旋等待.

各种锁的比较

锁的粗化

示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22public class VolatileDemo {

private static boolean isOver = false;

public static void main(String[] args) {

Thread thread = new Thread(new Runnable() {

public void run() {

System.out.println("测试1---"+isOver);

while (!isOver)

System.out.println(111);

System.out.println("测试2---"+isOver);

}

});

thread.start();

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

isOver = true;

}

}执行结果

立即打印测试1---false,然后一直循环打印111,循环1秒后打印测试2---true

分析System.out.println源码如下1

2

3

4

5

6public void println(String x) {

synchronized (this) {

print(x);

newLine();

}

}可以发现是println方法是加了synchronized的

jvm中对锁的优化有一条为锁的粗化如果一系列的连续操作都对同一个对象反复加锁和解锁,

甚至加锁操作是出现在循环体中的,那即使没有线程竞争,频繁地进行互斥同步操作也会导致不必要的性能损耗。

如果虚拟机探测到有这样一串零碎的操作都对同一个对象加锁,将会把加锁同步的范围扩展(膨胀)到整个操作序列的外部(由多次加锁编程只加锁一次)。1

2

3

4

5synchronized{

while(!isOver){

sout();

}

}所以synchronized会将isOver 的值在锁释放前刷回共享内存(共享内存也称为系统内存,也称为主内存)

修改示例

经过上面的理解,我们现在应该知道了该怎样解决了。更正后的代码为:

1 | public class SynchronizedDemo implements Runnable { |

开启十个线程,每个线程在原值上累加1,000,000次,最终正确的结果为10 * 1,000,000=10,000,000,

这里能够计算出正确的结果是因为在做累加操作时使用了同步代码块,这样就能保证每个线程所获得共享变量的值都是当前最新的值,

如果不使用同步的话,就可能会出现A线程累加后,而B线程做累加操作有可能是使用原来的就值,即“脏值”。这样,就导致最终的计算结果不是正确的。

而使用Syncnized就可能保证内存可见性,保证每个线程都是操作的最新值。

彻底理解volatile

volatile简介

通过之前的学习,我们了解到synchronized是阻塞式同步,在线程竞争激烈的情况下会升级为重量级锁。

而volatile就可以说是java虚拟机提供的最轻量级的同步机制。

但它同时不容易被正确理解,也至于在并发编程中很多程序员遇到线程安全的问题就会使用synchronized。

Java内存模型告诉我们,各个线程会将共享变量从主内存中拷贝到工作内存,然后执行引擎会基于工作内存中的数据进行操作处理。

线程在工作内存进行操作后何时会写到主内存中?

这个时机对普通变量是没有规定的,而针对volatile修饰的变量给java虚拟机特殊的约定,

线程对volatile变量的修改会立刻被其他线程所感知,即不会出现数据脏读的现象,从而保证数据的“可见性”。

现在我们有了一个大概的印象就是:被volatile修饰的变量能够保证每个线程能够获取该变量的最新值,从而避免出现数据脏读的现象。

volatile实现原理

volatile是怎样实现了?比如一个很简单的Java代码:

1 | instance = new Instancce() //instance是volatile变量 |

在生成汇编代码时会在volatile修饰的共享变量进行写操作的时候会多出Lock前缀的指令

我们想这个Lock指令肯定有神奇的地方,那么Lock前缀的指令在多核处理器下会发现什么事情了?

主要有这两个方面的影响:

- 将当前处理器缓存行的数据写回系统内存;

- 这个写回内存的操作会使得其他CPU里缓存了该内存地址的数据无效

为了提高处理速度,处理器不直接和内存进行通信,而是先将系统内存的数据读到内部缓存(L1,L2或其他)后再进行操作,但操作完不知道何时会写到内存。

如果对声明了volatile的变量进行写操作,JVM就会向处理器发送一条Lock前缀的指令,将这个变量所在缓存行的数据写回到系统内存。

但是,就算写回到内存,如果其他处理器缓存的值还是旧的,再执行计算操作就会有问题。

所以,在多处理器下,为了保证各个处理器的缓存是一致的,就会实现缓存一致性协议,每个处理器通过嗅探在总线上传播的数据来检查自己缓存的值是不是过期了,

当处理器发现自己缓存行对应的内存地址被修改,就会将当前处理器的缓存行设置成无效状态,当处理器对这个数据进行修改操作的时候,会重新从系统内存中把数据读到处理器缓存里。

因此,经过分析我们可以得出如下结论:

- Lock前缀的指令会引起处理器缓存写回内存;

- 一个处理器的缓存回写到内存会导致其他处理器的缓存失效;

- 当处理器发现本地缓存失效后,就会从内存中重读该变量数据,即可以获取当前最新值。

这样针对volatile变量通过这样的机制就使得每个线程都能获得该变量的最新值。

volatile的happens-before关系

经过上面的分析,我们已经知道了volatile变量可以通过缓存一致性协议保证每个线程都能获得最新值,即满足数据的“可见性”。

我一直将并发分析的切入点分为两个核心,三大性质。两个核心

- JMM(Java内存模型)包括:主内存(系统内存)和工作内存(线程内存)

- happens-before

三大性质

- 原子性

- 可见性

- 有序性

(关于三大性质的总结在以后得文章会和大家共同探讨)

废话不多说,先来看两个核心之一:volatile的happens-before关系。

在happens-before规则中有一条volatile变量规则:对一个volatile域的写,happens-before于任意后续对这个volatile域的读。

下面我们结合具体的代码,我们利用这条规则推导下:

1 | public class VolatileExample { |

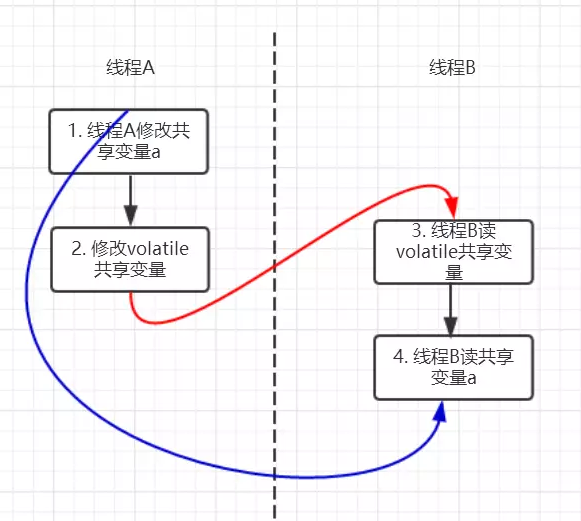

上面的实例代码对应的happens-before关系如下图所示:

加锁线程A先执行writer方法,然后线程B执行reader方法,图中每一个箭头两个节点就代码一个happens-before关系,黑色的代表根据程序顺序规则推导出来红色的是根据volatile变量的写happens-before 于任意后续对volatile变量的读蓝色的就是根据传递性规则推导出来的

这里的2 happen-before 3,同样根据happens-before规则定义:

如果A happens-before B,则A的执行结果对B可见,并且A的执行顺序先于B的执行顺序

我们可以知道操作2执行结果对操作3来说是可见的,也就是说当线程A将volatile变量 flag更改为true后线程B就能够迅速感知。

volatile的内存语义

还是按照两个核心的分析方式,分析完happens-before关系后我们现在就来进一步分析volatile的内存语义。

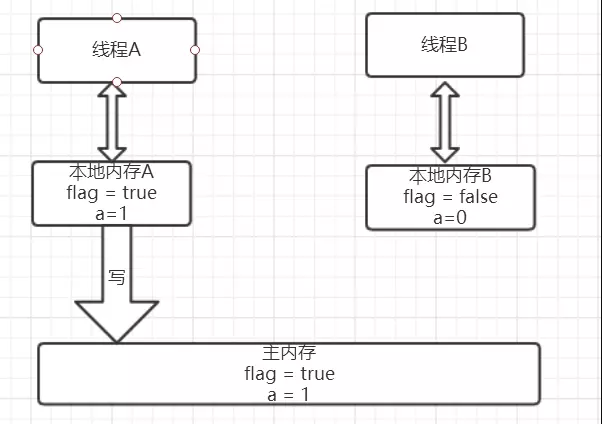

还是以上面的代码为例,假设线程A先执行writer方法,线程B随后执行reader方法,初始时线程的本地内存中flag和a都是初始状态,

下图是线程A执行volatile写后的状态图。

当volatile变量写后,线程中本地内存中共享变量就会置为失效的状态,因此线程B再需要读取从主内存中去读取该变量的最新值。

下图就展示了线程B读取同一个volatile变量的内存变化示意图。

从另外一个角度来看,线程A和线程B之间进行了一次通信,线程A在写volatile变量时,

实际上就像是给B发送了一个消息告诉线程B你现在的值都是旧的了,然后线程B读这个volatile变量时就像是接收了线程A刚刚发送的消息。

既然是旧的了,那线程B该怎么办了?自然而然就只能去主内存去取啦。

好的,我们现在两个核心:happens-before以及内存语义现在已经都了解清楚了。

是不是还不过瘾,突然发现原来自己会这么爱学习(微笑脸),那我们下面就再来一点干货—-volatile内存语义的实现。

内存语义的实现

我们都知道,为了性能优化,JMM在不改变正确语义的前提下,会允许编译器和处理器对指令序列进行重排序,

那如果想阻止重排序要怎么办了?答案是可以添加内存屏障。

内存屏障

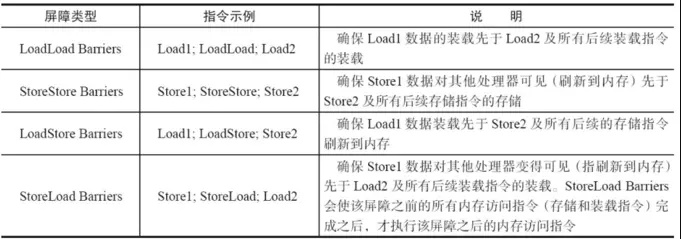

JMM内存屏障分为四类见下图,

Store写:将处理器缓存的数据刷新到内存中。(工作内存新值写入到主内存)

Load读:将内存存储的数据拷贝到处理器的缓存中。(工作内存中读取主内存的数据)

java编译器会在生成指令系列时在适当的位置会插入内存屏障指令来禁止特定类型的处理器重排序。

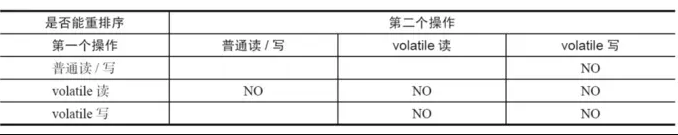

为了实现volatile的内存语义,JMM会限制特定类型的编译器和处理器重排序,JMM会针对编译器制定volatile重排序规则表:

“NO”表示禁止重排序。

为了实现volatile内存语义时,编译器在生成字节码时,会在指令序列中插入内存屏障来禁止特定类型的处理器重排序。

对于编译器来说,发现一个最优布置来最小化插入屏障的总数几乎是不可能的,为此,JMM采取了保守策略:

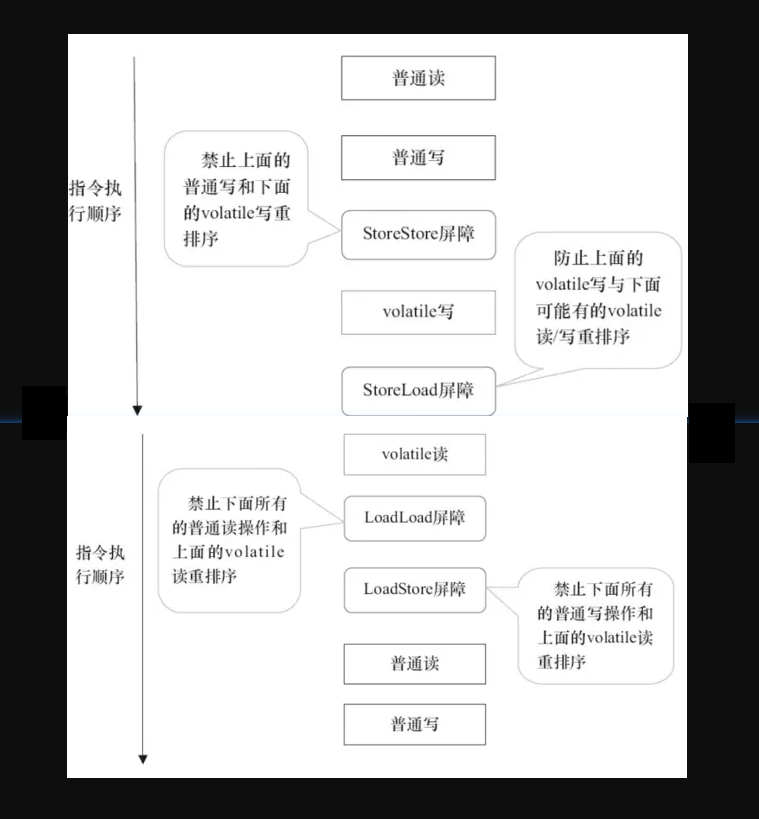

- 在每个volatile写操作的前面插入一个StoreStore屏障

- 在每个volatile写操作的后面插入一个StoreLoad屏障

- 在每个volatile读操作的后面插入一个LoadLoad屏障

- 在每个volatile读操作的后面插入一个LoadStore屏障

需要注意的是:volatile写操作是在前后分别插入内存屏障,而volatile读操作是在后面插入两个内存屏障StoreStore屏障禁止上面的普通写和下面的volatile写重排序;StoreLoad屏障防止上面的volatile写与下面可能有的volatile读/写重排序LoadLoad屏障禁止下面所有的普通读操作和上面的volatile读重排序LoadStore屏障禁止下面所有的普通写操作和上面的volatile读重排序

下面以两个示意图进行理解,图片摘自相当好的一本书《java并发编程的艺术》。

示例理解

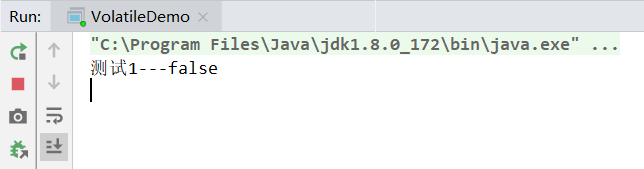

示例1,不加volatile关键字

示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21public class VolatileDemo {

private static boolean isOver = false;

public static void main(String[] args) {

Thread thread = new Thread(new Runnable() {

public void run() {

System.out.println("测试1---"+isOver);

while (!isOver);

System.out.println("测试2---"+isOver);

}

});

thread.start();

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

isOver = true;

}

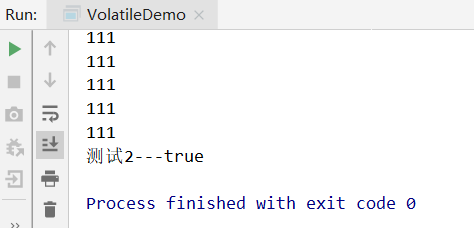

}执行结果

立即打印测试1---false,然后程序一直卡着,

分析

在main线程中将isOver改为了true后,thread的工作内存该变量值仍有效,所以会一直循环

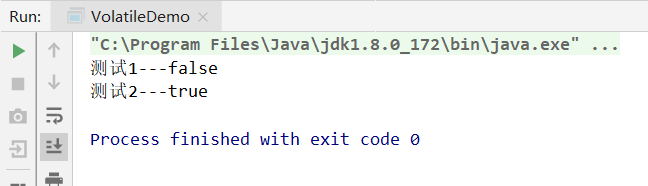

示例2,加volatile关键字

示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21public class VolatileDemo {

private static boolean isOver = false;

public static void main(String[] args) {

Thread thread = new Thread(new Runnable() {

public void run() {

System.out.println("测试1---"+isOver);

while (!isOver);

System.out.println("测试2---"+isOver);

}

});

thread.start();

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

isOver = true;

}

}执行结果

立即打印测试1---false,再过1秒打印测试2---true,然后结束进程

分析

注意不同点,现在已经将isOver设置成了volatile变量,这样在main线程中将isOver改为了true后,thread的工作内存该变量值就会失效,从而需要再次从主内存中读取该值,

现在能够读出isOver最新值为true从而能够结束在thread里的死循环,从而能够顺利停止掉thread线程。

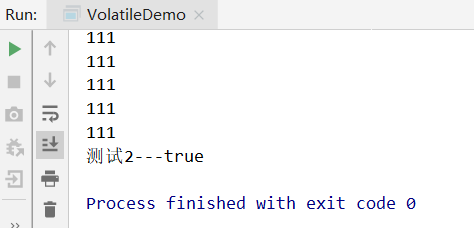

示例3,不加volatile关键字,循环打印,锁的粗化

示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22public class VolatileDemo {

private static boolean isOver = false;

public static void main(String[] args) {

Thread thread = new Thread(new Runnable() {

public void run() {

System.out.println("测试1---"+isOver);

while (!isOver)

System.out.println(111);

System.out.println("测试2---"+isOver);

}

});

thread.start();

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

isOver = true;

}

}执行结果

立即打印测试1---false,然后一直循环打印111,循环1秒后打印测试2---true

分析System.out.println源码如下1

2

3

4

5

6public void println(String x) {

synchronized (this) {

print(x);

newLine();

}

}可以发现是println方法是加了synchronized的

jvm中对锁的优化有一条为锁的粗化如果一系列的连续操作都对同一个对象反复加锁和解锁,

甚至加锁操作是出现在循环体中的,那即使没有线程竞争,频繁地进行互斥同步操作也会导致不必要的性能损耗。

如果虚拟机探测到有这样一串零碎的操作都对同一个对象加锁,将会把加锁同步的范围扩展(膨胀)到整个操作序列的外部(由多次加锁编程只加锁一次)。1

2

3

4

5synchronized{

while(!isOver){

sout();

}

}所以synchronized会将isOver 的值在锁释放前刷回共享内存(共享内存也称为系统内存,也称为主内存)

volatile是否能保证数组中元素的可见性?

问

一个线程向volatile的数组中设置值,而另一个线程向volatile的数组中读取。

比如seg.setValue(2),随后另一个线程调用seg.getValue(2),前一个线程设置的值对读取的线程是可见的吗?

1 | public class Seg { |

答

volatile的数组只针对数组的引用具有volatile的语义,而不是它的元素

在后面的COW(CopyOnWriteArrayList)中为什么需要复制呢? 如果将array 数组设定为volatile的, 对volatile变量写happens-before读,读线程不是能够感知到volatile变量的变化吗?

就可以使用这个进行回答.

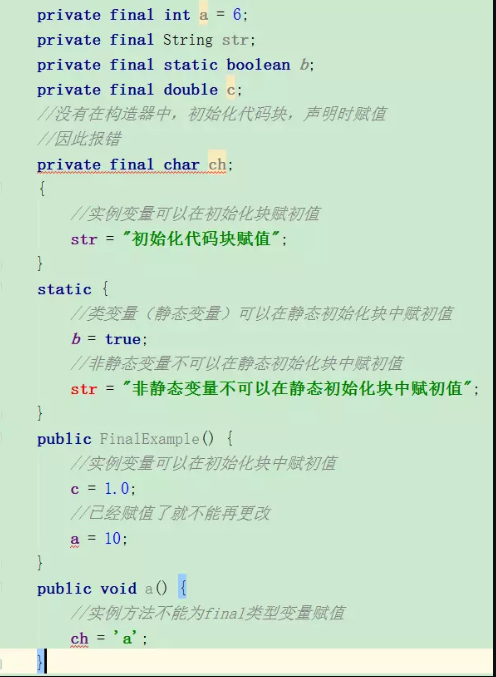

你以为你真的了解final吗?

final的简介

final可以修饰变量 方法 类,用于表示所修饰的内容一旦赋值之后就不会再被改变,

比如String类就是一个final类型的类。

即使能够知道final具体的使用方法,我想对final在多线程中存在的重排序问题也很容易忽略,希望能够一起做下探讨。

final的具体使用场景

final能够修饰变量,方法和类,也就是final使用范围基本涵盖了java每个地方,

下面就分别以锁修饰的位置:变量,方法和类分别来说一说。

变量

在java中变量,可以分为成员变量以及方法局部变量。因此也是按照这种方式依次来说,以避免漏掉任何一个死角。

成员变量

通常每个类中的成员变量可以分为类变量(static修饰的变量)以及实例变量。

针对这两种类型的变量赋初值的时机是不同的,

类变量有两个时机赋初值,而实例变量则可以有三个时机赋初值。类变量

- 声明时赋初值

- 静态代码块中赋初值

实例变量 - 声明时赋初值

- 非静态代码块中赋初值

- 构造器中赋初值

当final变量未初始化时系统不会进行隐式初始化,会出现报错。

这样说起来还是比较抽象,下面用具体的代码来演示。(代码涵盖了final修饰变量所有的可能情况,耐心看下去会有收获的:) )

看上面的图片已经将每种情况整理出来了,这里用截图的方式也是觉得在IDE出现红色出错的标记更能清晰的说明情况。

现在我们来将这几种情况归纳整理一下:

类变量:必须要在静态初始化块中指定初始值或者声明该类变量时指定初始值,而且只能在这两个地方之一进行指定;实例变量:必要要在非静态初始化块,声明该实例变量或者在构造器中指定初始值,而且只能在这三个地方进行指定。

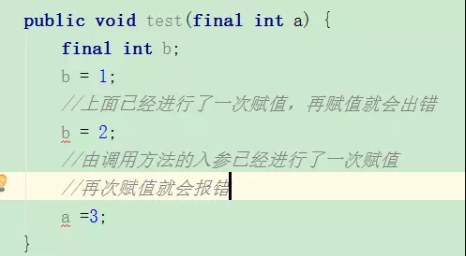

局部变量

final局部变量由程序员进行显式初始化,

- 如果final局部变量已经

进行了初始化则后面就不能再次进行更改, - 如果final变量

未进行初始化,可以进行赋值,当且仅有一次赋值,一旦赋值之后再次赋值就会出错。

下面用具体的代码演示final局部变量的情况:

final基本数据类型 VS final引用数据类型

现在我们来换一个角度进行考虑,final修饰的是基本数据类型和引用类型有区别吗?

通过上面的例子我们已经看出来,如果final修饰的是一个基本数据类型的数据,一旦赋值后就不能再次更改,

那么,如果final是引用数据类型了?这个引用的对象能够改变吗?我们同样来看一段代码。

1 | public class FinalExample { |

当我们对final修饰的引用数据类型变量person的属性改成22,是可以成功操作的。

通过这个实验我们就可以看出来:

- 当final修饰基本数据类型变量时,不能对基本数据类型变量重新赋值,因此基本数据类型变量不能被改变。

- 而对于引用类型变量而言,它仅仅保存的是一个引用,final只保证这个引用类型变量所引用的地址不会发生改变,即一直引用这个对象,但这个对象属性是可以改变的。

宏变量

利用final变量的不可更改性,在满足一下三个条件时,该变量就会成为一个“宏变量”,即是一个常量。

- 使用final修饰符修饰;

- 在定义该final变量时就指定了初始值;

- 该初始值在编译时就能够唯一指定。

注意:当程序中其他地方使用该宏变量的地方,编译器会直接替换成该变量的值

方法

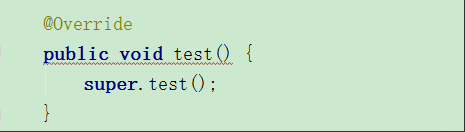

重写?

当父类的方法被final修饰的时候,子类不能重写父类的该方法,

比如在Object中,getClass()方法就是final的,我们就不能重写该方法,但是hashCode()方法就不是被final所修饰的,我们就可以重写hashCode()方法。

我们还是来写一个例子来加深一下理解: 先定义一个父类,里面有final修饰的方法test();

1 | public class FinalExampleParent { |

然后FinalExample继承该父类,当重写test()方法时出现报错,如下图:

通过这个现象我们就可以看出来被final修饰的方法不能够被子类所重写。

重载?

1 | public class FinalExampleParent { |

可以看出被final修饰的方法是可以重载的。

经过我们的分析可以得出如下结论:

- 父类的final方法是不能够被子类重写的

- final方法是可以被重载的

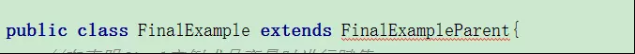

类

当一个类被final修饰时,表明该类是不能被子类继承的。

子类继承往往可以重写父类的方法和改变父类属性,会带来一定的安全隐患,因此,当一个类不希望被继承时就可以使用final修饰。

还是来写一个小例子:

1 | public final class FinalExampleParent { |

父类会被final修饰,当子类继承该父类的时候,就会报错,如下图:

final的例子

final经常会被用作不变类上,利用final的不可更改性。我们先来看看什么是不变类。

不变类的意思是创建该类的实例后,该实例的实例变量是不可改变的。

满足以下条件则可以成为不可变类:

- 使用private和final修饰符来修饰该类的成员变量

- 提供带参的构造器用于初始化类的成员变量;

- 仅为该类的成员变量提供getter方法,不提供setter方法,因为普通方法无法修改fina修饰的成员变量;

- 如果有必要就重写Object类 的hashCode()和equals()方法,应该保证用equals()判断相同的两个对象其Hashcode值也是相等的。

JDK中提供的八个包装类和String类都是不可变类,我们来看看String的实现。

1 | /** The value is used for character storage. */ |

可以看出String的value就是final修饰的,上述其他几条性质也是吻合的。

多线程中你真的了解final吗?

上面我们聊的final使用,应该属于Java基础层面的,当理解这些后我们就真的算是掌握了final吗?

有考虑过final在多线程并发的情况吗?

在java内存模型中我们知道java内存模型为了能让处理器和编译器底层发挥他们的最大优势,对底层的约束就很少,也就是说针对底层来说java内存模型就是弱内存数据模型。

同时,处理器和编译为了性能优化会对指令序列有编译器和处理器重排序。

那么,在多线程情况下,final会进行怎样的重排序?会导致线程安全的问题吗?下面,就来看看final的重排序。

final域重排序规则

final域为基本类型重排序规则

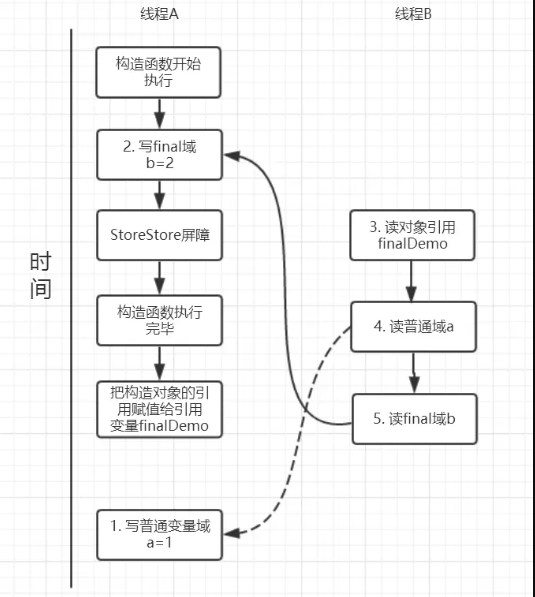

假设线程A在执行writer()方法,线程B执行reader()方法。

1 | public class FinalDemo { |

写final域重排序规则

写final域的重排序规则禁止对final域的写重排序到构造函数之外,

这个规则的实现主要包含了两个方面:

- JMM禁止编译器把final域的写重排序到构造函数之外;

- 编译器会在final域写之后,构造函数return之前,插入一个storestore屏障关于内存屏障。这个屏障可以禁止处理器把final域的写重排序到构造函数之外。

我们再来分析writer方法,虽然只有一行代码,但实际上做了两件事情:

- 构造了一个FinalDemo对象;

- 把这个对象赋值给成员变量finalDemo。

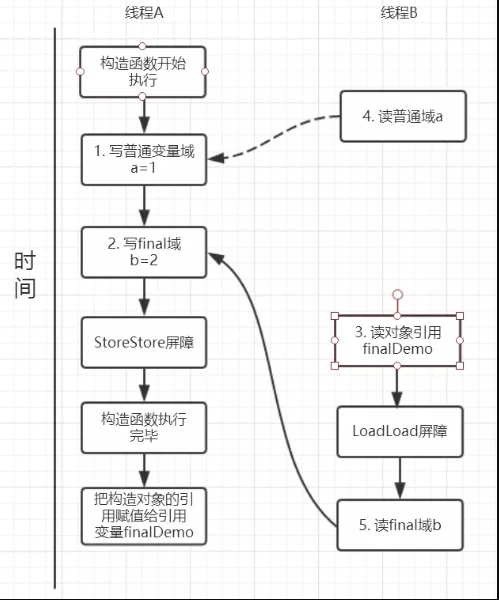

我们来画下存在的一种可能执行时序图,如下:

由于a,b之间没有数据依赖性,普通域(普通变量)a可能会被重排序到构造函数之外,线程B就有可能读到的是普通变量a初始化之前的值(零值),这样就可能出现错误。

而final域变量b,根据重排序规则,会禁止final修饰的变量b重排序到构造函数之外,从而b能够正确赋值,线程B就能够读到final变量初始化后的值。

因此,写final域的重排序规则可以确保:在对象引用为任意线程可见之前,对象的final域已经被正确初始化过了,而普通域就不具有这个保障。

比如在上例,线程B有可能就是一个未正确初始化的对象finalDemo。

读final域重排序规则

注意,这个规则仅仅是针对处理器

读final域重排序规则为:在一个线程中,初次读对象引用和初次读该对象包含的final域,JMM会禁止这两个操作的重排序。处理器会在读final域操作的前面插入一个LoadLoad屏障。

实际上,读对象的引用和读该对象的final域存在间接依赖性,一般处理器不会重排序这两个操作。但是有一些处理器会重排序,因此,这条禁止重排序规则就是针对这些处理器而设定的。

read()方法主要包含了三个操作:

- 初次读引用变量finalDemo;

- 初次读引用变量finalDemo的普通域a;

- 初次读引用变量finalDemo的final与b;

假设线程A写过程没有重排序,那么线程A和线程B有一种的可能执行时序为下图:

读对象的普通域被重排序到了读对象引用的前面就会出现线程B还未读到对象引用就在读取该对象的普通域变量,这显然是错误的操作。

而final域的读操作就“限定”了在读final域变量前已经读到了该对象的引用,从而就可以避免这种情况。

读final域的重排序规则可以确保:在读一个对象的final域之前,一定会先读这个包含这个final域的对象的引用。

final域为引用类型重排序规则

我们已经知道了final域是基本数据类型的时候重排序规则是怎么的了?如果是引用数据类型了?我们接着继续来探讨。

对final修饰的对象的成员域写操作

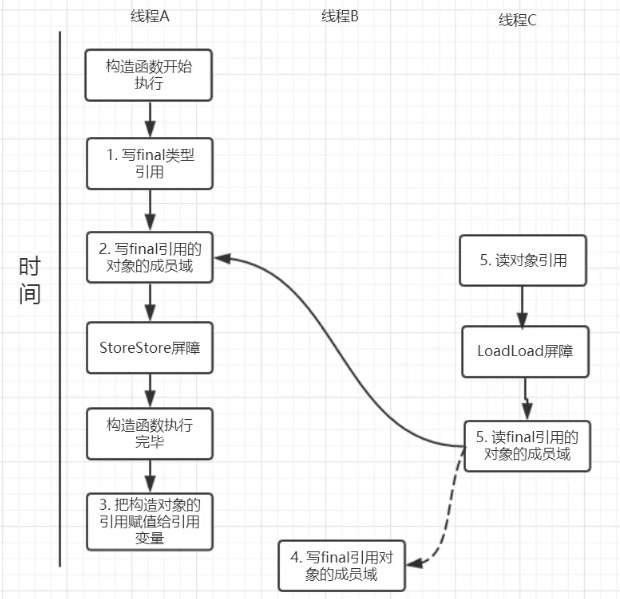

针对引用数据类型,final域写针对编译器和处理器重排序增加了这样的约束:在构造函数内对一个final修饰的对象的成员域的写入,与随后在构造函数之外把这个被构造的对象的引用赋给一个引用变量,这两个操作是不能被重排序的。

注意这里的是“增加了这样的约束”也就说前面对final基本数据类型的重排序规则在这里还是使用。

这句话是比较拗口的,下面结合实例来看。

1 | public class FinalReferenceDemo { |

针对上面的实例程序,线程线程A执行wirterOne方法,执行完后线程B执行writerTwo方法,然后线程C执行reader方法。

下图就以这种执行时序出现的一种情况来讨论(耐心看完才有收获)。

由于对final域的写禁止重排序到构造方法外,因此1和3不能被重排序。

由于一个final域的引用对象的成员域写入不能与随后将这个被构造出来的对象赋给引用变量重排序,因此2和3不能重排序。

对final修饰的对象的成员域读操作

JMM可以确保线程C至少能看到写线程A对final引用的对象的成员域的写入,即能看下arrays[0] = 1,而写线程B对数组元素的写入可能看到可能看不到。

JMM不保证线程B的写入对线程C可见,线程B和线程C之间存在数据竞争,此时的结果是不可预知的。如果可见的,可使用锁或者volatile。

关于final重排序的总结

按照final修饰的数据类型分类:

- 基本数据类型:

- final域写:禁止

final域写与构造方法重排序,即禁止final域写重排序到构造方法之外,从而保证该对象对所有线程可见时,该对象的final域全部已经初始化过。 - final域读:禁止初次

读对象的引用与读该对象包含的final域的重排序。

- final域写:禁止

- 引用数据类型:

- 额外增加约束:禁止在构造函数对

一个final修饰的对象的成员域的写入与随后将这个被构造的对象的引用赋值给引用变量重排序

- 额外增加约束:禁止在构造函数对

final的实现原理

上面我们提到过,写final域会要求编译器在final域写之后,构造函数返回前插入一个StoreStore屏障(内存屏障)。

读final域的重排序规则会要求编译器在读final域的操作前插入一个LoadLoad屏障。

注意:x86=32位 x64=64位

计算机属性可查看

很有意思的是,如果以X86处理为例,X86不会对写-写重排序,所以StoreStore屏障可以省略。

由于不会对有间接依赖性的操作重排序,所以在X86处理器中,读final域需要的LoadLoad屏障也会被省略掉。

也就是说,以X86为例的话,对final域的读/写的内存屏障都会被省略!具体是否插入还是得看是什么处理器

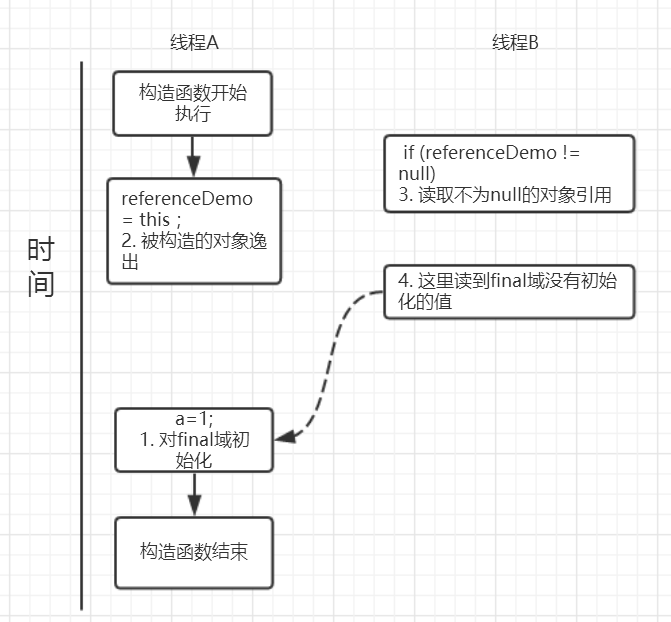

为什么final引用不能从构造函数中“溢出”?

这里还有一个比较有意思的问题:上面对final域写重排序规则可以确保我们在使用一个对象引用的时候该对象的final域已经在构造函数被初始化过了。

但是这里其实是有一个前提条件的,也就是:在构造函数,不能让这个被构造的对象被其他线程可见,也就是说该对象引用不能在构造函数中“逸出”。

以下面的例子来说:

1 | public class FinalReferenceEscapeDemo { |

可能的执行时序如图所示:

假设一个线程A执行writer方法另一个线程执行reader方法。

因为构造函数中操作1和2之间没有数据依赖性,1和2可以重排序,先执行了2,这个时候引用对象referenceDemo是个没有完全初始化的对象,而当线程B去读取该对象时就会出错。

尽管依然满足了final域写重排序规则:在引用对象对所有线程可见时,其final域已经完全初始化成功。

但是,引用对象“this”逸出,该代码依然存在线程安全的问题。

三大性质总结:原子性、可见性以及有序性

三大性质简介

在并发编程中分析线程安全的问题时往往需要切入点,那就是两个核心,三大性质。

1 | 两个核心 |

关于synchronized和volatile已经讨论过了,就想着将并发编程中这两大神器在原子性 有序性 可见性上做一个比较,

当然这也是面试中的高频考点,值得注意。

synchronized: 具有原子性,有序性和可见性;

volatile:具有有序性和可见性

原子性

原子性是指一个操作是不可中断的,要么全部执行成功要么全部执行失败,有着“同生共死”的感觉。

及时在多个线程一起执行的时候,一个操作一旦开始,就不会被其他线程所干扰。

我们先来看看哪些是原子操作,哪些不是原子操作,有一个直观的印象:

1 | int a = 10; //1 |

上面这四个语句中只有第1个语句是原子操作,将10赋值给线程工作内存的变量a,

而语句2(a++),实际上包含了三个操作:1. 读取变量a的值;2:对a进行加一的操作;3.将计算后的值再赋值给变量a,而这三个操作无法构成原子操作。

对语句3,4的分析同理可得这两条语句不具备原子性。

当然,java内存模型中定义了8种操作都是原子的,不可再分的。

- lock(锁定):作用于主内存中的变量,它把一个变量标识为一个线程独占的状态;

- unlock(解锁):作用于主内存中的变量,它把一个处于锁定状态的变量释放出来,释放后的变量才可以被其他线程锁定

- read(读取):作用于主内存的变量,它把一个变量的值从主内存传输到线程的工作内存中,以便后面的load动作使用;

- load(载入):作用于工作内存中的变量,它把read操作从主内存中得到的变量值放入工作内存中的变量副本

- use(使用):作用于工作内存中的变量,它把工作内存中一个变量的值传递给执行引擎,每当虚拟机遇到一个需要使用到变量的值的字节码指令时将会执行这个操作;

- assign(赋值):作用于工作内存中的变量,它把一个从执行引擎接收到的值赋给工作内存的变量,每当虚拟机遇到一个给变量赋值的字节码指令时执行这个操作;

- store(存储):作用于工作内存的变量,它把工作内存中一个变量的值传送给主内存中以便随后的write操作使用;

- write(操作):作用于主内存的变量,它把store操作从工作内存中得到的变量的值放入主内存的变量中。

上面的这些指令操作是相当底层的,可以作为扩展知识面掌握下。

那么如何理解这些指令了?

比如,把一个变量从主内存中复制到工作内存中就需要执行read,load操作,将工作内存同步到主内存中就需要执行store,write操作。

注意的是:java内存模型只是要求上述两个操作是顺序执行的并不是连续执行的。

也就是说read和load之间可以插入其他指令,store和writer可以插入其他指令。

比如对主内存中的a,b进行访问就可以出现这样的操作顺序:read a,read b, load b,load a。

由原子性变量操作read,load,use,assign,store,write,可以大致认为基本数据类型的访问读写具备原子性(例外就是long和double的非原子性协定)

synchronized

上面一共有八条原子操作,其中六条可以满足基本数据类型的访问读写具备原子性,还剩下lock和unlock两条原子操作。

如果我们需要更大范围的原子性操作就可以使用lock和unlock原子操作。

尽管jvm没有把lock和unlock开放给我们使用,但jvm以更高层次的指令monitorenter和monitorexit指令开放给我们使用,反应到java代码中就是synchronized关键字,也就是说synchronized满足原子性。

volatile

我们先来看这样一个例子:

1 | public class VolatileExample { |

开启10个线程,每个线程都自加10,000次,如果不出现线程安全的问题最终的结果应该就是:10*10,000 = 100,000;

可是运行多次都是小于100,000的结果,问题在于volatile并不能保证原子性

在前面说过counter++这并不是一个原子操作,包含了三个步骤:1.读取变量counter的值;2.对counter加一;3.将新值赋值给变量counter。

如果线程A读取counter到工作内存后,其他线程对这个值已经做了自增操作后,那么线程A的这个值自然而然就是一个过期的值,因此,总结果必然会是小于100,000的。

如果让volatile保证原子性,必须符合以下两条规则:

1.运算结果并不依赖于变量的当前值,或者能够确保只有一个线程修改变量的值;

2.变量不需要与其他的状态变量共同参与不变约束

有序性

synchronized

synchronized语义表示锁在同一时刻只能由一个线程进行获取,当锁被占用后,其他线程只能等待。

因此,synchronized语义就要求线程在访问读写共享变量时只能“串行”执行,因此synchronized具有有序性。

volatile

在java内存模型中说过,为了性能优化,编译器和处理器会进行指令重排序;

也就是说java程序天然的有序性可以总结为:如果在本线程内观察,所有的操作都是有序的;如果在一个线程观察另一个线程,所有的操作都是无序的。

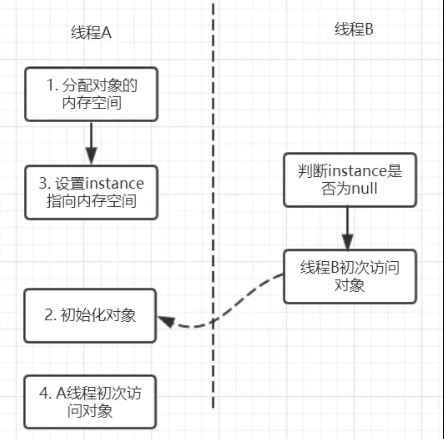

在单例模式的实现上有一种双重检验锁(DCL)(Double-checked Locking)的方式。代码如下:

1 | public class Singleton { |

这里为什么要加volatile了?我们先来分析一下不加volatile的情况,有问题的语句是这条:

1 | instance = new Singleton(); |

这条语句实际上包含了三个操作:1.分配对象的内存空间;2.初始化对象;3.设置instance指向刚分配的内存地址。

但由于存在重排序的问题,可能有以下的执行顺序:

如果2和3进行了重排序的话,线程B进行判断if(instance==null)时就会为true,而实际上这个instance并没有初始化成功,显而易见对线程B来说之后的操作就会是错得。

而用volatile修饰的话就可以禁止2和3操作重排序,从而避免这种情况。

所以,volatile包含禁止指令重排序的语义,其具有有序性。

可见性

可见性是指当一个线程修改了共享变量后,其他线程能够立即得知这个修改。

- 通过之前对synchronzed内存语义进行了分析,当线程获取锁时会从主内存中获取共享变量的最新值,释放锁的时候会将共享变量同步到主内存中。从而,synchronized具有可见性。

- 同样的在volatile分析中,会通过在指令中添加lock指令,以实现内存可见性。因此, volatile具有可见性

总结

通过这篇文章,主要是比较了synchronized和volatile在三条性质:原子性 可见性 有序性的情况,归纳如下:

synchronized: 具有原子性,有序性和可见性;

volatile:具有有序性和可见性

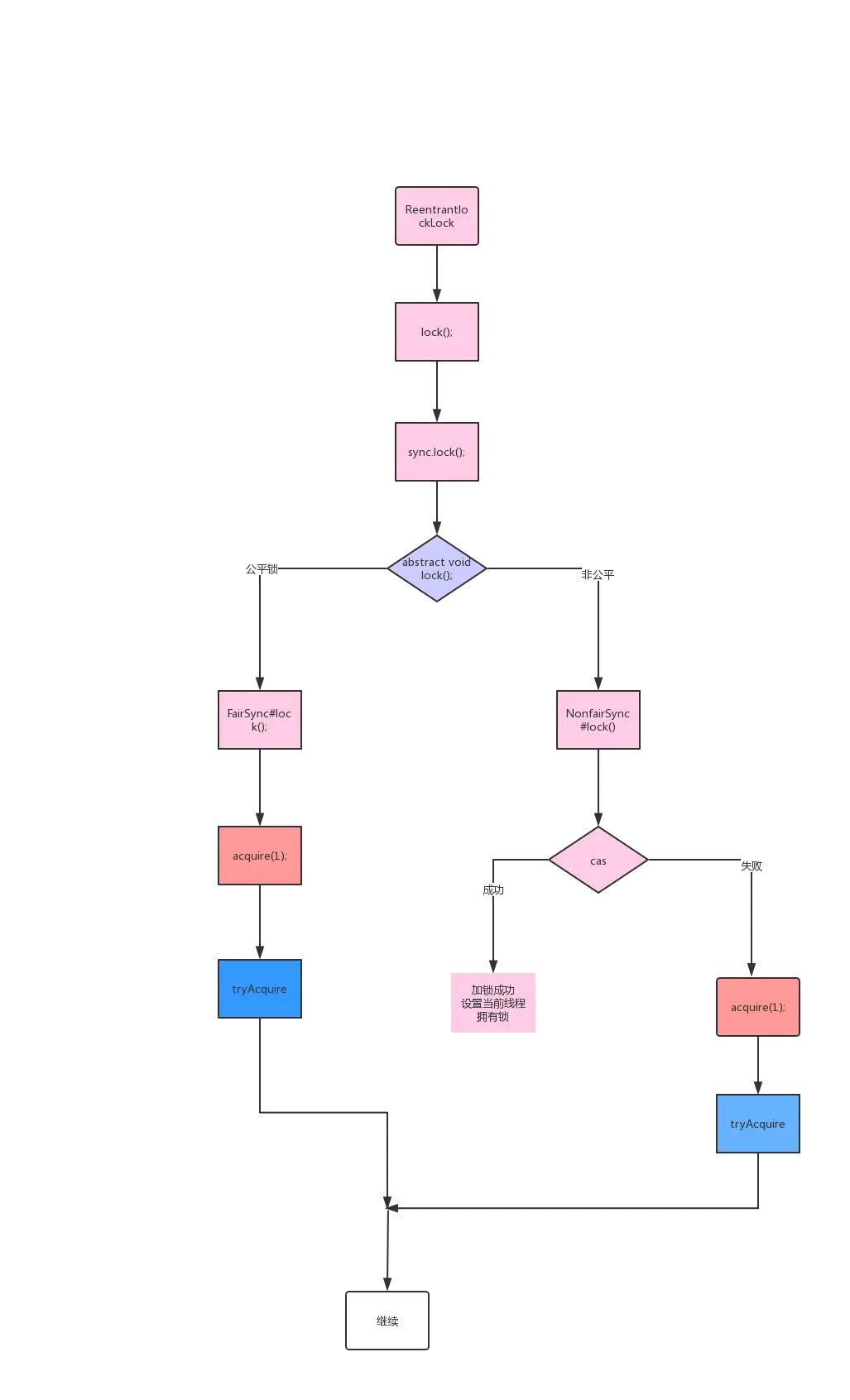

初识Lock与AbstractQueuedSynchronizer(AQS)

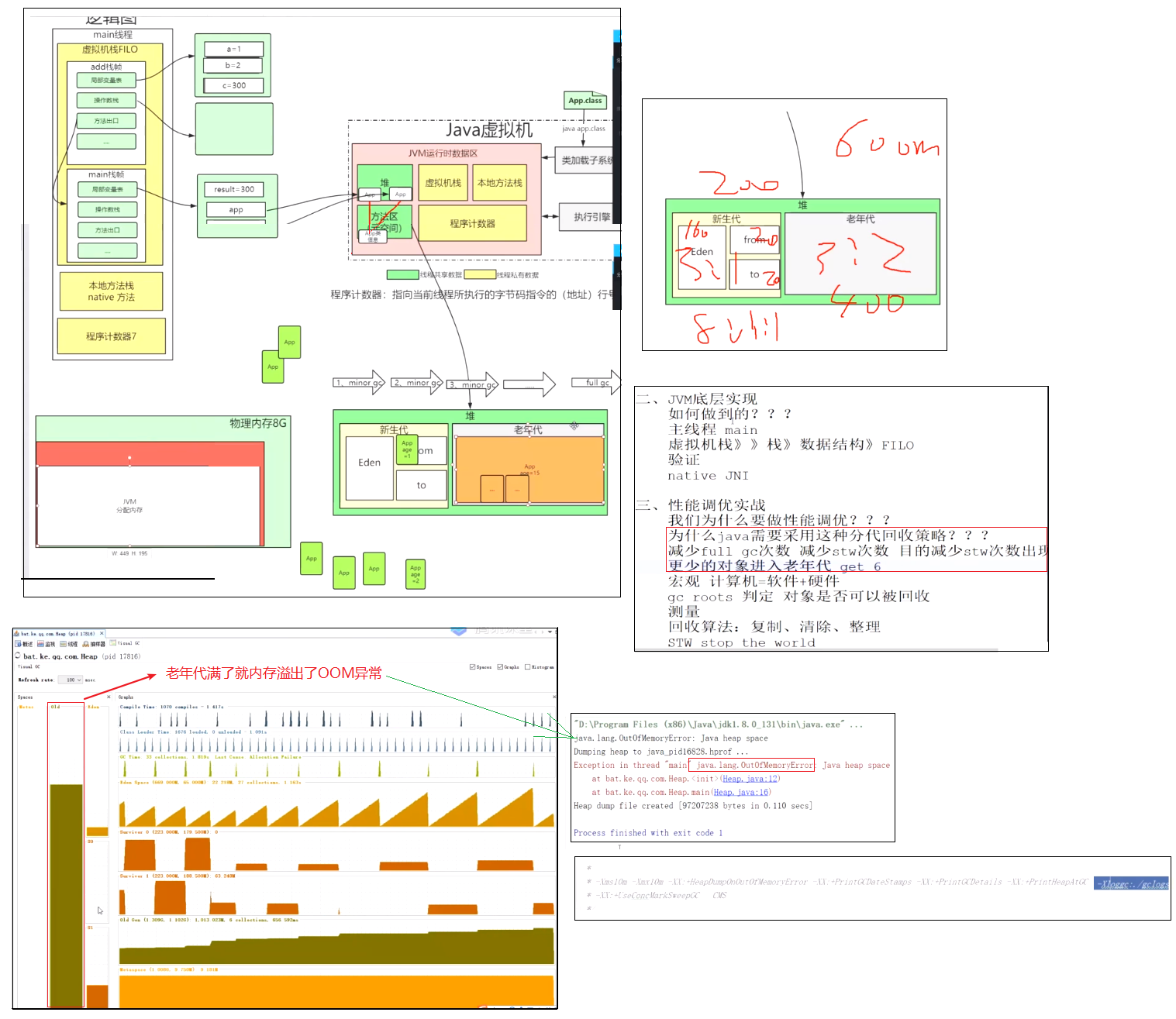

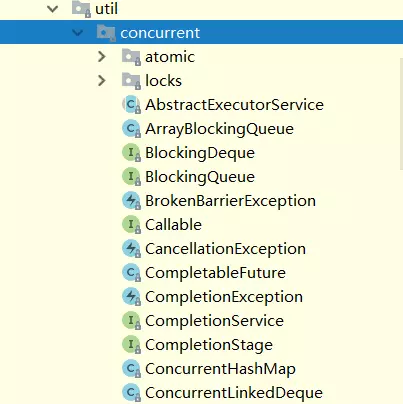

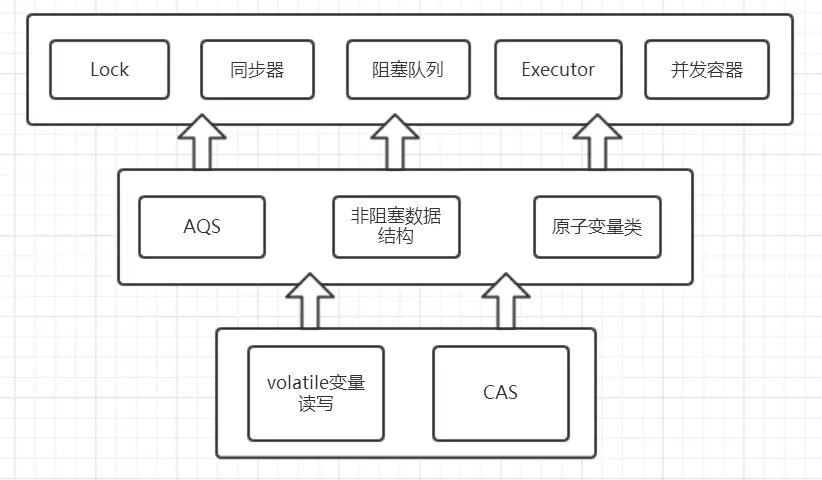

concurrent包的结构层次

在针对并发编程中,Doug Lea大师为我们提供了大量实用,高性能的工具类,针对这些代码进行研究会让我们队并发编程的掌握更加透彻也会大大提升我们队并发编程技术的热爱。

这些代码在java.util.concurrent包下。如下图,即为concurrent包的目录结构图。

其中包含了两个子包:atomic以及lock,另外在concurrent下的阻塞队列以及executors,这些就是concurrent包中的精华,之后会慢慢进行学习。

而这些类的实现主要是依赖于volatile以及CAS(在之前我们已经提到),从整体上来看concurrent包的整体实现图如下图所示:

lock简介

我们下面来看concurent包下的lock子包。

锁是用来控制多个线程访问共享资源的方式,一般来说,一个锁能够防止多个线程同时访问共享资源。

在Lock接口出现之前,java程序主要是靠synchronized关键字实现锁功能的,而java SE5之后,并发包中增加了lock接口,它提供了与synchronized一样的锁功能。

虽然它失去了像synchronize关键字隐式加锁解锁的便捷性,但是却拥有了锁获取和释放的可操作性,可中断的获取锁以及超时获取锁等多种synchronized关键字所不具备的同步特性。

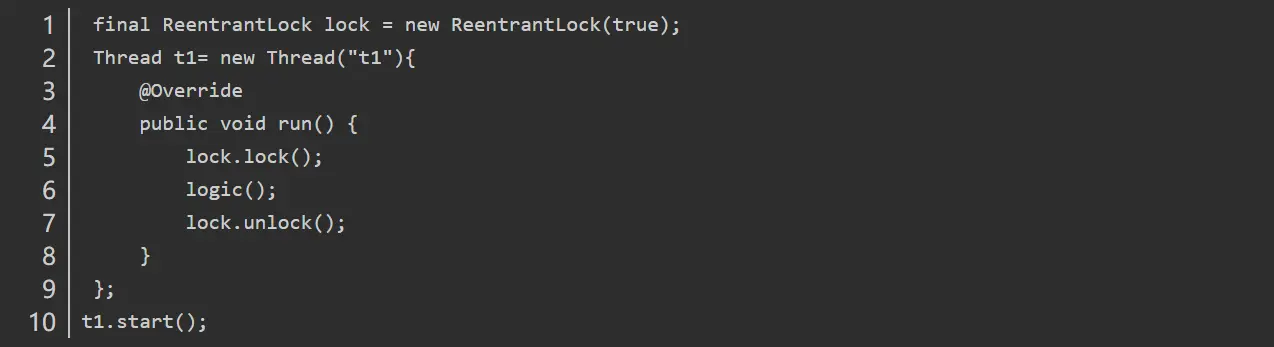

通常使用显示使用lock的形式如下:

1 | Lock lock = new ReentrantLock(); |

需要注意的是synchronized同步块执行完成或者遇到异常是锁会自动释放,而lock必须调用unlock()方法释放锁,因此在finally块中释放锁。

Lock接口API

我们现在就来看看lock接口定义了哪些方法:

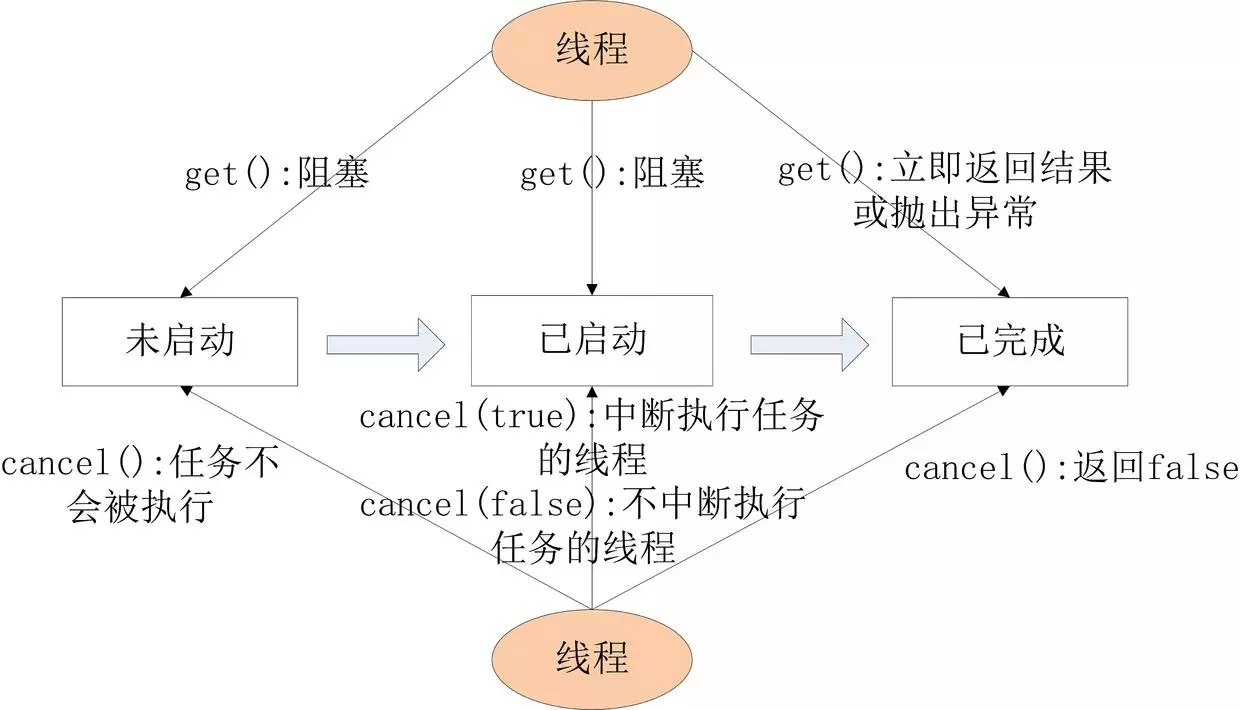

void lock();//获取锁void lockInterruptibly() throws InterruptedException;//获取锁的过程能够响应中断boolean tryLock();//非阻塞式响应中断能立即返回,获取锁返回true反之返回fasleboolean tryLock(long time, TimeUnit unit) throws InterruptedException;//超时获取锁,在超时内或者未中断的情况下能够获取锁Condition newCondition();//获取与lock绑定的等待通知组件,当前线程必须获得了锁才能进行等待,进行等待时会先释放锁,当再次获取锁时才能从等待中返回

那么在locks包下有哪些类实现了该接口了?先从最熟悉的ReentrantLock说起。

1 | public class ReentrantLock implements Lock, java.io.Serializable |

很显然ReentrantLock实现了lock接口,接下来我们来仔细研究一下它是怎样实现的。

当你查看源码时你会惊讶的发现ReentrantLock并没有多少代码,另外有一个很明显的特点是:

基本上所有的方法的实现实际上都是调用了其静态内存类Sync中的方法,而Sync类继承了AbstractQueuedSynchronizer(AQS)。

可以看出要想理解ReentrantLock关键核心在于对队列同步器AbstractQueuedSynchronizer(AQS)(简称同步器)的理解。

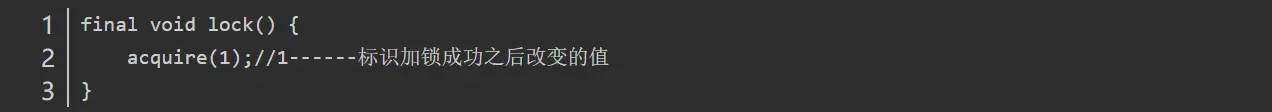

初识AQS

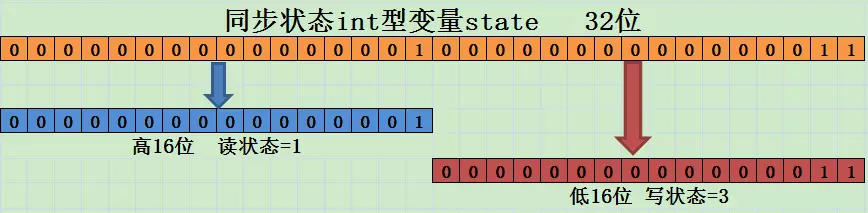

同步器是用来构建锁和其他同步组件的基础框架,它的实现主要依赖一个int成员变量(state)来表示同步状态以及通过一个FIFO队列构成等待队列。

它的子类必须重写AQS的几个protected修饰的用来改变同步状态的方法,其他方法主要是实现了排队和阻塞机制。

状态的更新使用getState,setState以及compareAndSetState这三个方法。

子类被推荐定义为自定义同步组件的静态内部类,同步器自身没有实现任何同步接口,它仅仅是定义了若干同步状态的获取和释放方法来供自定义同步组件的使用,

同步器既支持独占式获取同步状态,也可以支持共享式获取同步状态,这样就可以方便的实现不同类型的同步组件。

同步器是实现锁(也可以是任意同步组件)的关键,在锁的实现中聚合同步器,利用同步器实现锁的语义。

可以这样理解二者的关系:

锁Lock是面向使用者,它定义了使用者与锁交互的接口,隐藏了实现细节;同步器AQS是面向锁的实现者,它简化了锁的实现方式,屏蔽了同步状态的管理,线程的排队,等待和唤醒等底层操作。

锁和同步器很好的隔离了使用者和实现者所需关注的领域。

AQS的模板方法设计模式

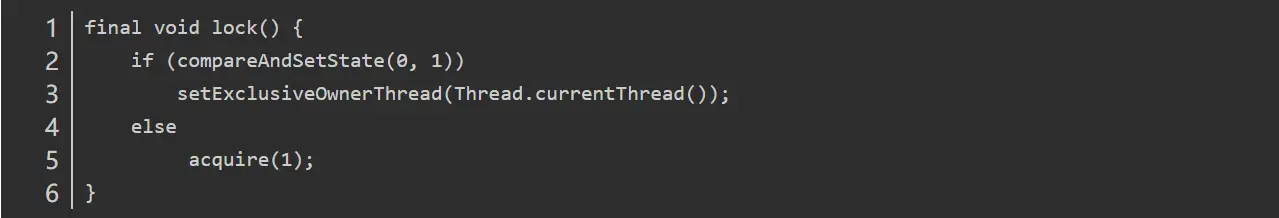

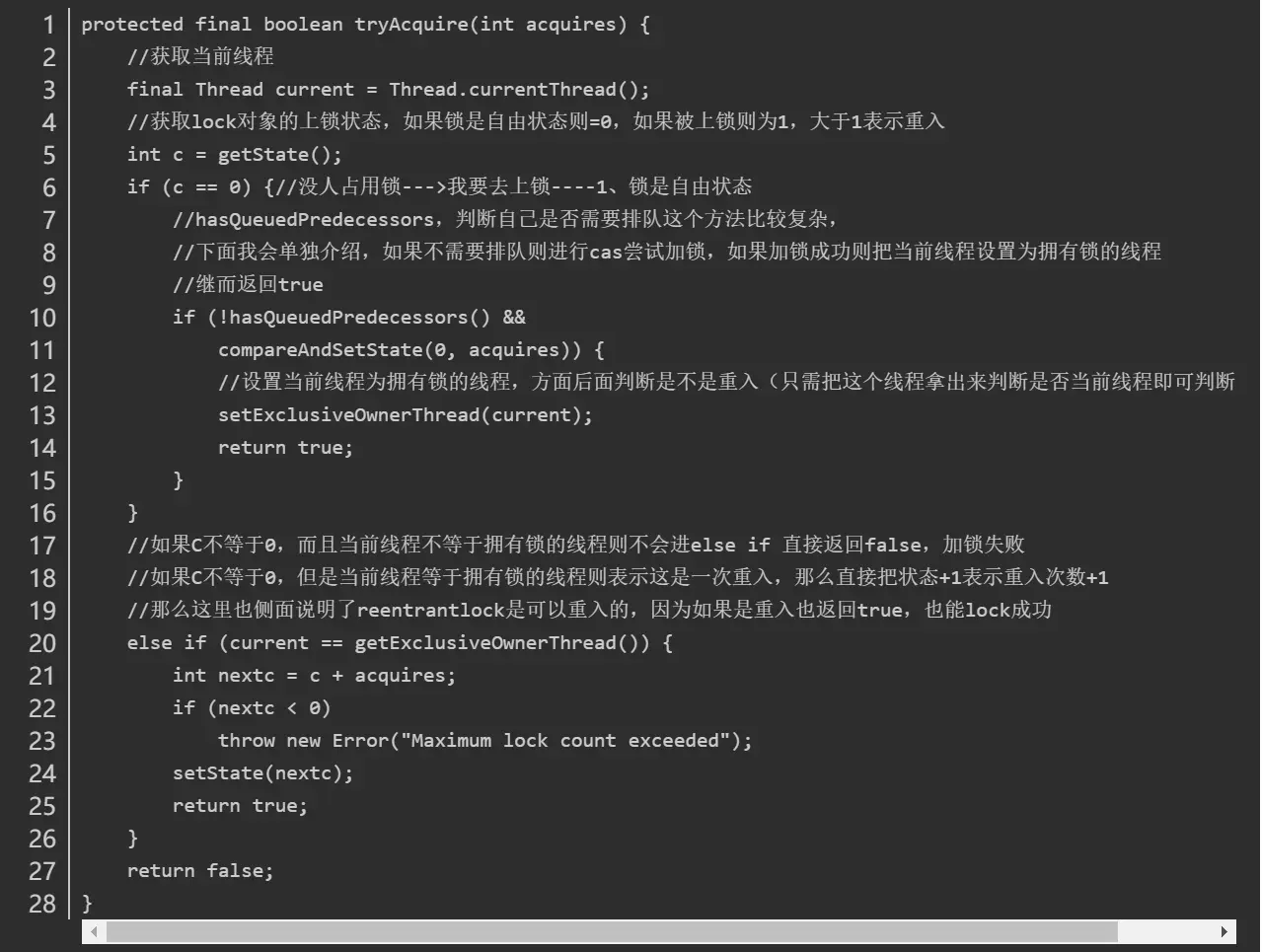

AQS的设计是使用模板方法设计模式,它将一些方法开放给子类进行重写,而同步器给同步组件所提供模板方法又会重新调用被子类所重写的方法。

举个例子,AQS中需要重写的方法tryAcquire:

1 | protected boolean tryAcquire(int arg) { |

ReentrantLock中NonfairSync(继承AQS)会重写该方法为:

1 | protected final boolean tryAcquire(int acquires) { |

而AQS中的模板方法acquire():

1 | public final void acquire(int arg) { |

此时当继承AQS的NonfairSync调用模板方法acquire时就会调用已经被NonfairSync重写的tryAcquire方法。

这就是使用AQS的方式,在弄懂这点后会lock的实现理解有很大的提升。

可以归纳总结为这么几点:

- 同步组件(这里不仅仅指锁,还包括CountDownLatch等)的实现依赖于同步器AQS,在同步组件实现中,使用AQS的方式被推荐定义继承AQS的静态内存类;

- AQS采用模板方法进行设计,AQS的protected修饰的方法需要由继承AQS的子类进行重写实现,当调用方法时就会调用被重写的方法;

- AQS负责同步状态的管理,线程的排队,等待和唤醒这些底层操作,而Lock等同步组件主要专注于实现同步语义;

- 在重写AQS的方式时,使用AQS提供的getState(),setState(),compareAndSetState()方法进行修改同步状态

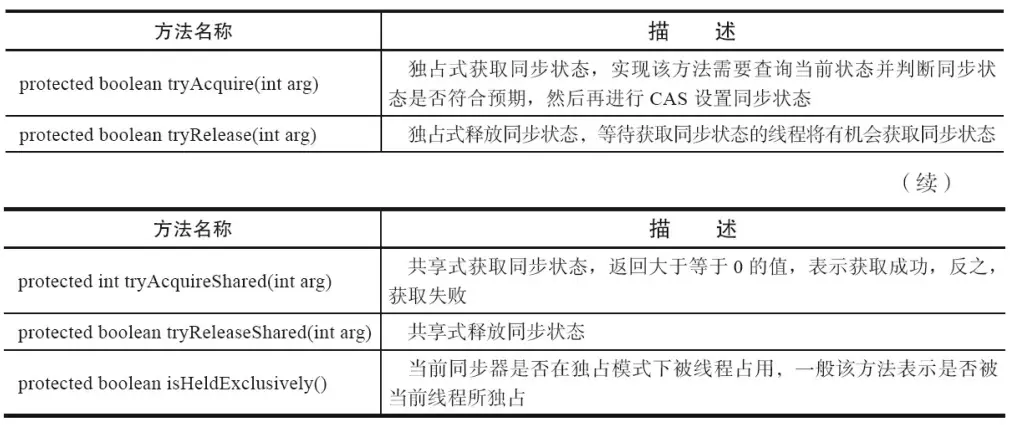

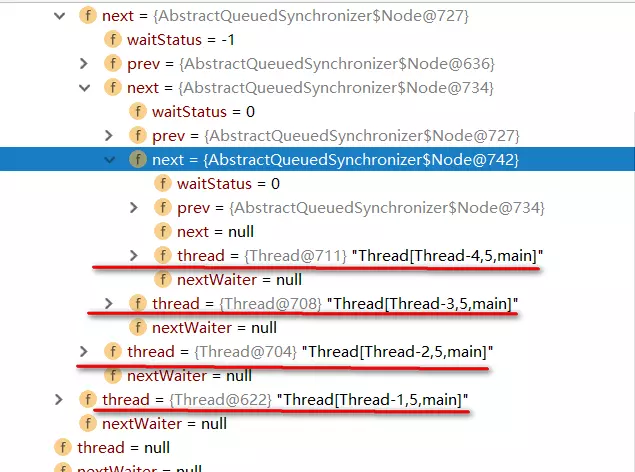

AQS可重写的方法如下图(摘自《java并发编程的艺术》一书):

在实现同步组件时AQS提供的模板方法如下图:

AQS提供的模板方法可以分为3类:

- 独占式获取与释放同步状态;

- 共享式获取与释放同步状态;

- 查询同步队列中等待线程情况;

同步组件通过AQS提供的模板方法实现自己的同步语义。

一个例子

下面使用一个例子来进一步理解下AQS的使用。这个例子也是来源于AQS源码中的example。

1 | class Mutex implements Lock, java.io.Serializable { |

1 | public class MutextDemo { |

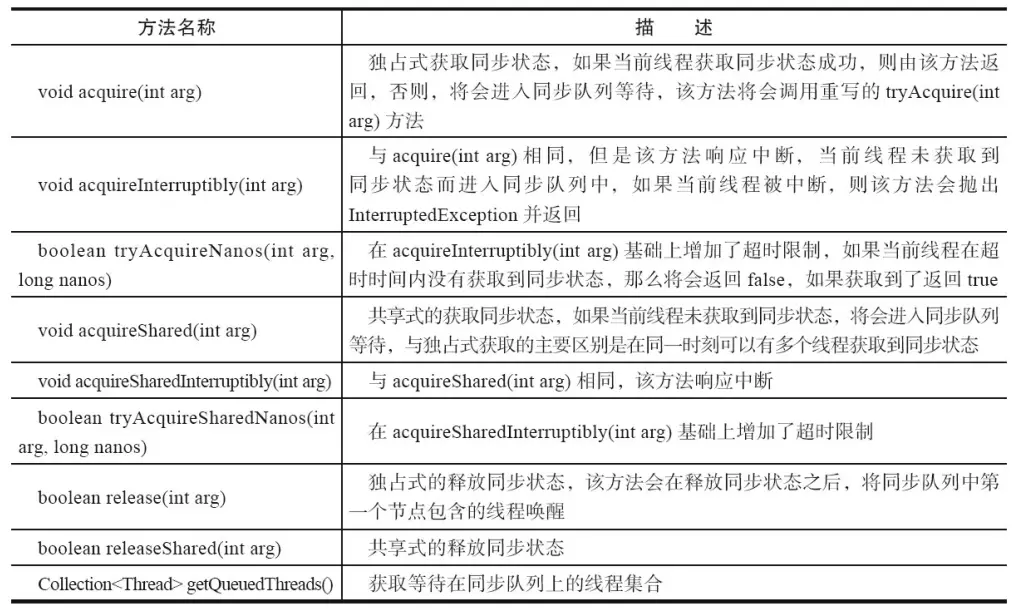

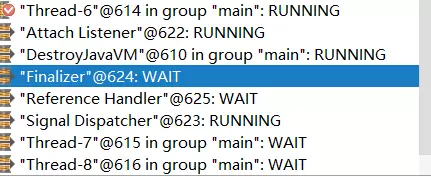

- 执行情况:

上面的这个例子实现了独占锁的语义,在同一个时刻只允许一个线程占有锁。

MutexDemo新建了10个线程,分别睡眠3s。

从执行情况也可以看出来当前Thread-6正在执行占有锁而其他Thread-7,Thread-8等线程处于WAIT状态。

按照推荐的方式,Mutex定义了一个继承AQS的静态内部类Sync,并且重写了AQS的tryAcquire等等方法,而对state的更新也是利用了setState(),getState(),compareAndSetState()这三个方法。

在实现实现lock接口中的方法也只是调用了AQS提供的模板方法(因为Sync继承AQS)。

从这个例子就可以很清楚的看出来,在同步组件的实现上主要是利用了AQS,而AQS封装了同步状态的修改,线程排队等底层实现,通过AQS的模板方法可以很方便的给同步组件的实现者进行调用。

而针对用户来说,只需要调用同步组件提供的方法来实现并发编程即可。

同时在新建一个同步组件时需要把握的两个关键点是:

- 实现同步组件时推荐定义继承AQS的静态内存类,并重写需要的protected修饰的方法;

- 同步组件语义的实现依赖于AQS的模板方法,而AQS模板方法又依赖于被AQS的子类所重写的方法(调用方法实际调用的是重写方法)。

通俗点说,因为AQS整体设计思路采用模板方法设计模式,同步组件以及AQS的功能实际上划分成各自的两部分:

AQS实现者的角度

通过可重写的方法:独占式: tryAcquire()(独占式获取同步状态),tryRelease()(独占式释放同步状态);

共享式 :tryAcquireShared()(共享式获取同步状态),tryReleaseShared()(共享式释放同步状态);

告诉AQS怎样判断当前同步状态是否成功获取或者是否成功释放。

同步组件专注于对当前同步状态的逻辑判断,从而实现自己的同步语义。

这句话比较抽象,举例来说,上面的Mutex例子中通过tryAcquire方法实现自己的同步语义,在该方法中如果当前同步状态为0(即该同步组件没被任何线程获取),当前线程可以获取同时将状态更改为1返回true,否则,该组件已经被线程占用返回false。

很显然,该同步组件只能在同一时刻被线程占用,Mutex专注于获取释放的逻辑来实现自己想要表达的同步语义。

AQS的角度

而对AQS来说,只需要同步组件返回的true和false即可,因为AQS会对true和false会有不同的操作,true会认为当前线程获取同步组件成功直接返回,而false的话就AQS也会将当前线程插入同步队列等一系列的方法。

总的来说,同步组件通过重写AQS的方法实现自己想要表达的同步语义,而AQS只需要同步组件表达的true和false即可,AQS会针对true和false不同的情况做不同的处理,至于底层实现,可以看下面介绍。

深入理解AbstractQueuedSynchronizer(AQS)

AQS简介

在上面文章中我们对lock和AbstractQueuedSynchronizer(AQS)有了初步的认识。

在同步组件的实现中,AQS是核心部分,同步组件的实现者通过使用AQS提供的模板方法实现同步组件语义,AQS则实现了对同步状态的管理,以及对阻塞线程进行排队,等待通知等等一些底层的实现处理。

AQS的核心也包括了这些方面:同步队列 独占式锁的获取和释放 共享锁的获取和释放以及可中断锁 超时等待锁获取这些特性的实现,而这些实际上则是AQS提供出来的模板方法

归纳整理如下:独占式锁

void acquire(int arg);独占式获取同步状态,如果获取失败则插入同步队列进行等待;void acquireInterruptibly(int arg);与acquire方法相同,但在同步队列中进行等待的时候可以检测中断;boolean tryAcquireNanos(int arg, long nanosTimeout);在acquireInterruptibly基础上增加了超时等待功能,在超时时间内没有获得同步状态返回false;boolean release(int arg);释放同步状态,该方法会唤醒在同步队列中的下一个节点

共享式锁

void acquireShared(int arg);共享式获取同步状态,与独占式的区别在于同一时刻有多个线程获取同步状态;void acquireSharedInterruptibly(int arg);在acquireShared方法基础上增加了能响应中断的功能;boolean tryAcquireSharedNanos(int arg, long nanosTimeout);在acquireSharedInterruptibly基础上增加了超时等待的功能;boolean releaseShared(int arg);共享式释放同步状态

要想掌握AQS的底层实现,其实也就是对这些模板方法的逻辑进行学习。

在学习这些模板方法之前,我们得首先了解下AQS中的同步队列是一种什么样的数据结构,因为同步队列是AQS对同步状态的管理的基石。

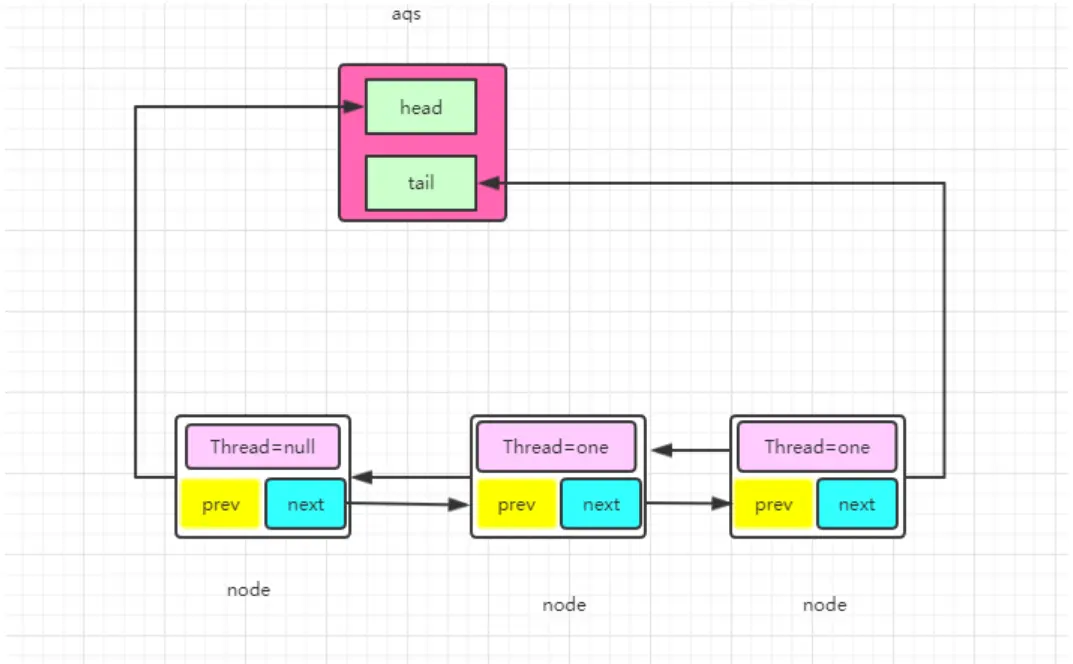

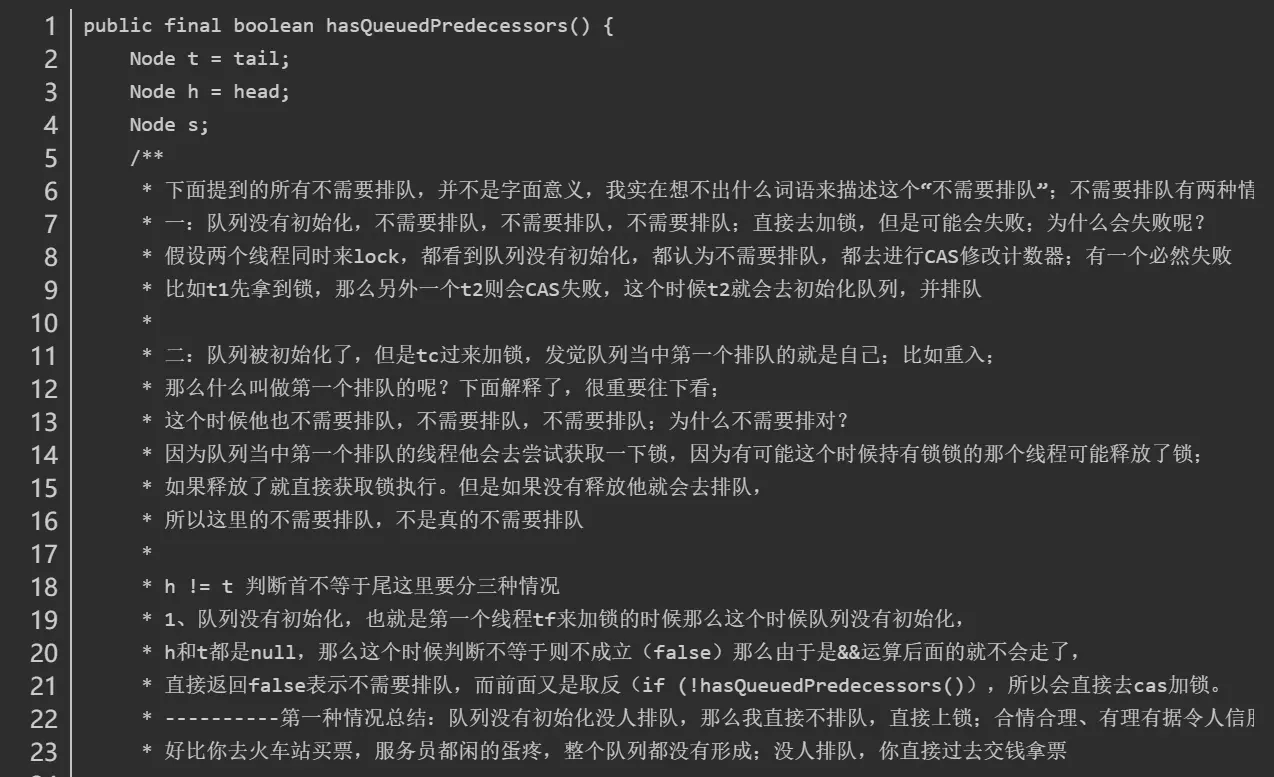

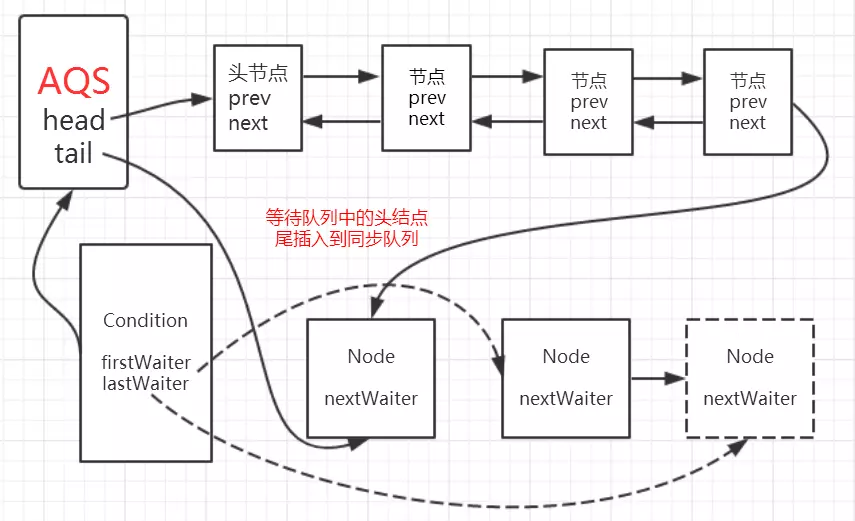

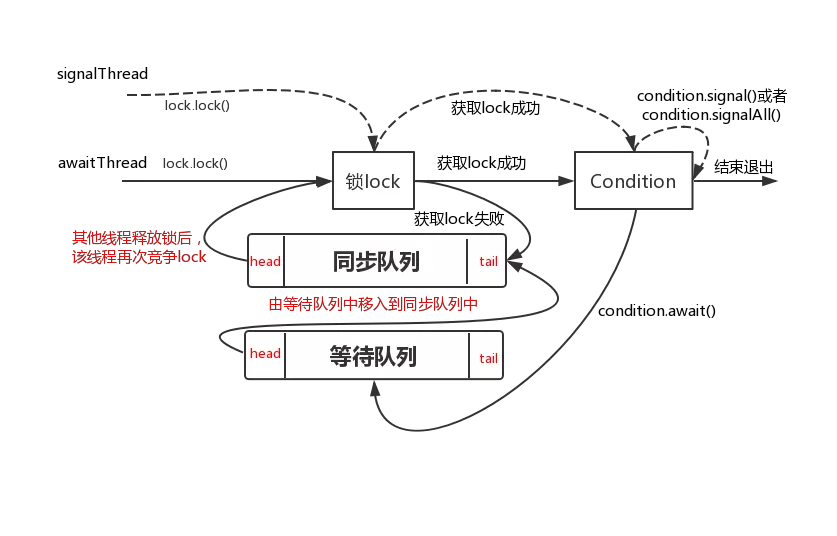

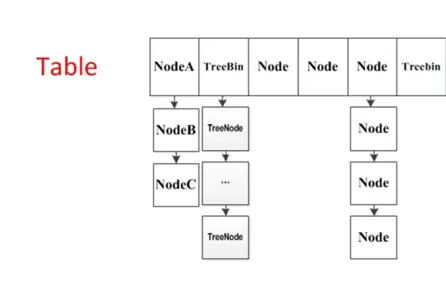

同步队列

当共享资源被某个线程占有,其他请求该资源的线程将会阻塞,从而进入同步队列。

就数据结构而言,队列的实现方式无外乎两者一是通过数组的形式,另外一种则是链表的形式。AQS中的同步队列则是通过链式方式进行实现。

接下来,很显然我们至少会抱有这样的疑问:

1. 节点的数据结构是什么样的?2. 是单向还是双向?3. 是带头节点的还是不带头节点的?

我们依旧先是通过看源码的方式。

在AQS有一个静态内部类Node,其中有这样一些属性:

1 | volatile int waitStatus //节点状态 |

waitStatus节点状态:

1 | 状态字段,只接受值: |

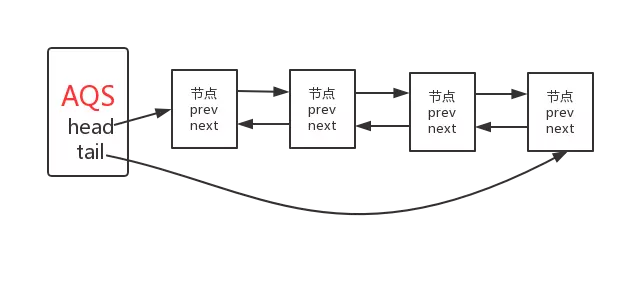

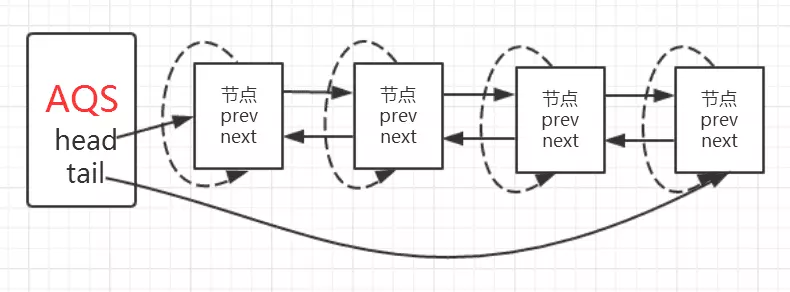

现在我们知道了节点的数据结构类型,并且每个节点拥有其上一个和下一个节点,很显然这是一个双向队列。

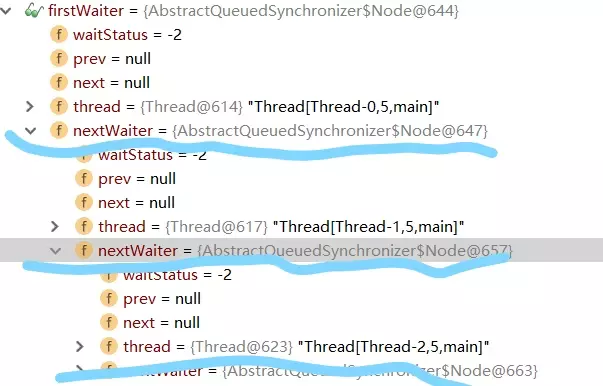

同样的我们可以用一段demo看一下。

1 | public class LockDemo { |

实例代码中开启了5个线程,先获取锁之后再睡眠10S中,实际上这里让线程睡眠是想模拟出当线程无法获取锁时进入同步队列的情况。

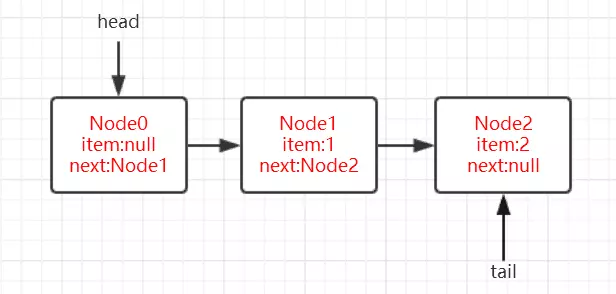

通过debug,当Thread-4(在本例中最后一个线程)获取锁失败后进入同步时,AQS时现在的同步队列如图所示:

Thread-0先获得锁后进行睡眠,其他线程(Thread-1,Thread-2,Thread-3,Thread-4)获取锁失败进入同步队列,同时也可以很清楚的看出来每个节点有两个域:prev(上一个)和next(下一个),并且每个节点用来保存获取同步状态失败的线程引用以及等待状态等信息。

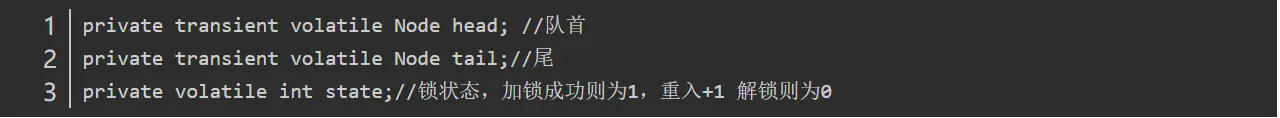

另外AQS中有两个重要的成员变量:

1 | private transient volatile Node head; |

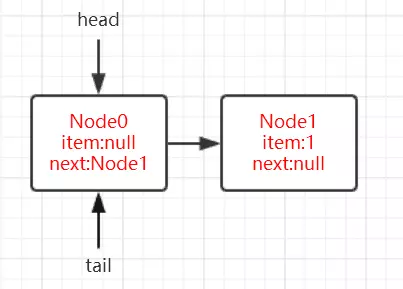

也就是说AQS实际上通过头尾指针来管理同步队列,同时实现包括获取锁失败的线程进行入队,释放锁时对同步队列中的线程进行通知等核心方法。

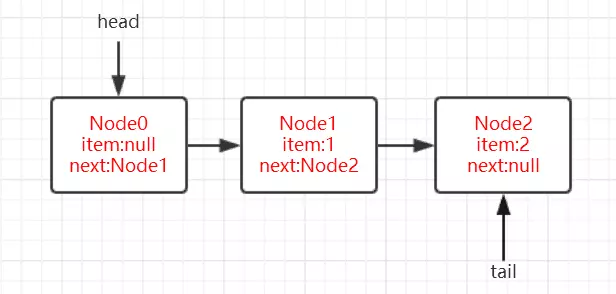

其示意图如下:

通过对源码的理解以及做实验的方式,现在我们可以清楚的知道这样几点:

- 节点的数据结构,即AQS的静态内部类Node,节点的等待状态等信息

- 同步队列是一个双向队列,AQS通过持有头尾指针管理同步队列

那么,节点如何进行入队和出队是怎样做的了?

实际上这对应着锁的获取和释放两个操作:

- 获取锁成功进行出队操作。

- 获取锁失败进行入队操作

独占锁

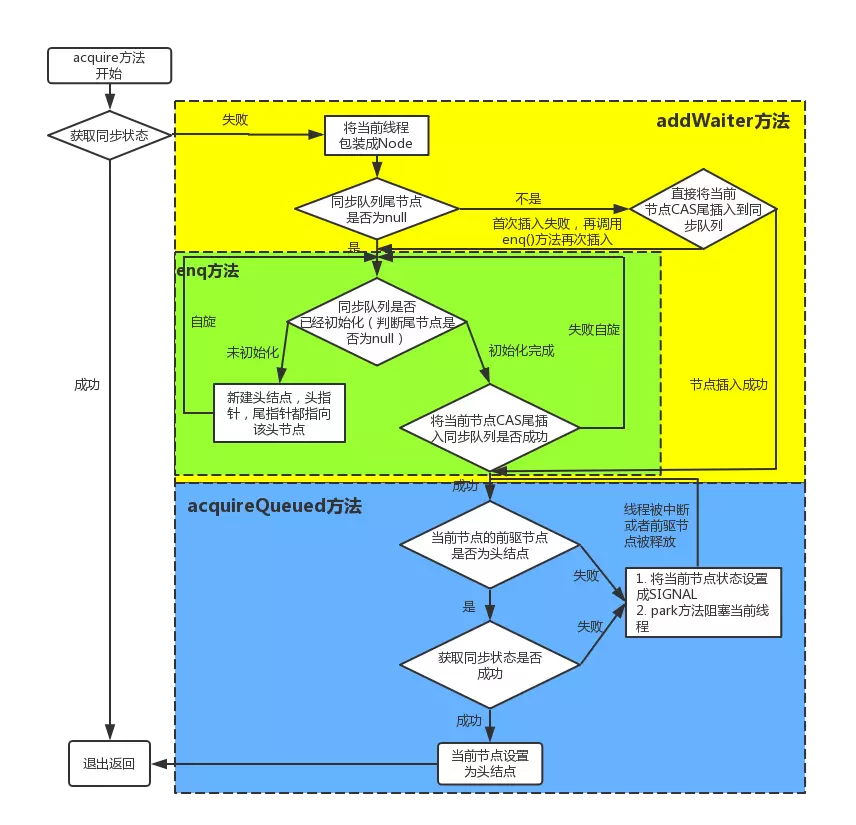

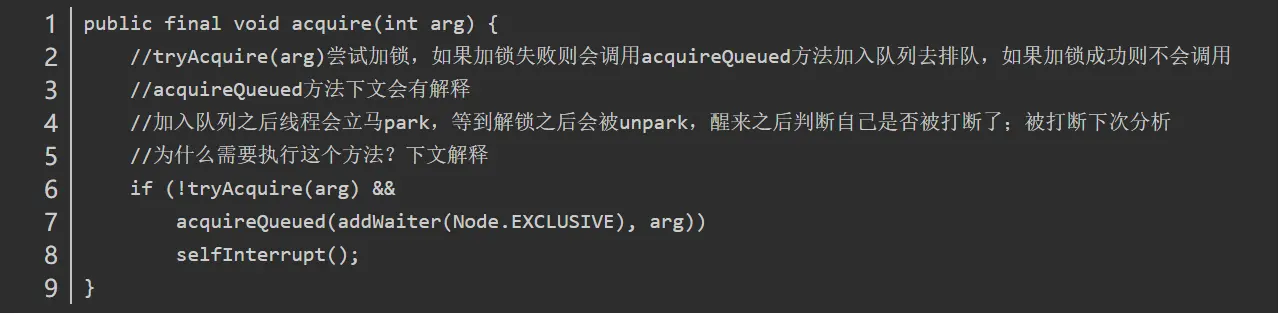

独占锁的获取(acquire方法)

我们继续通过看源码和debug的方式来看,还是以上面的demo为例,调用lock()方法是获取独占式锁,获取失败就将当前线程加入同步队列,成功则线程执行。

而lock()方法实际上会调用AQS的acquire()方法,源码如下

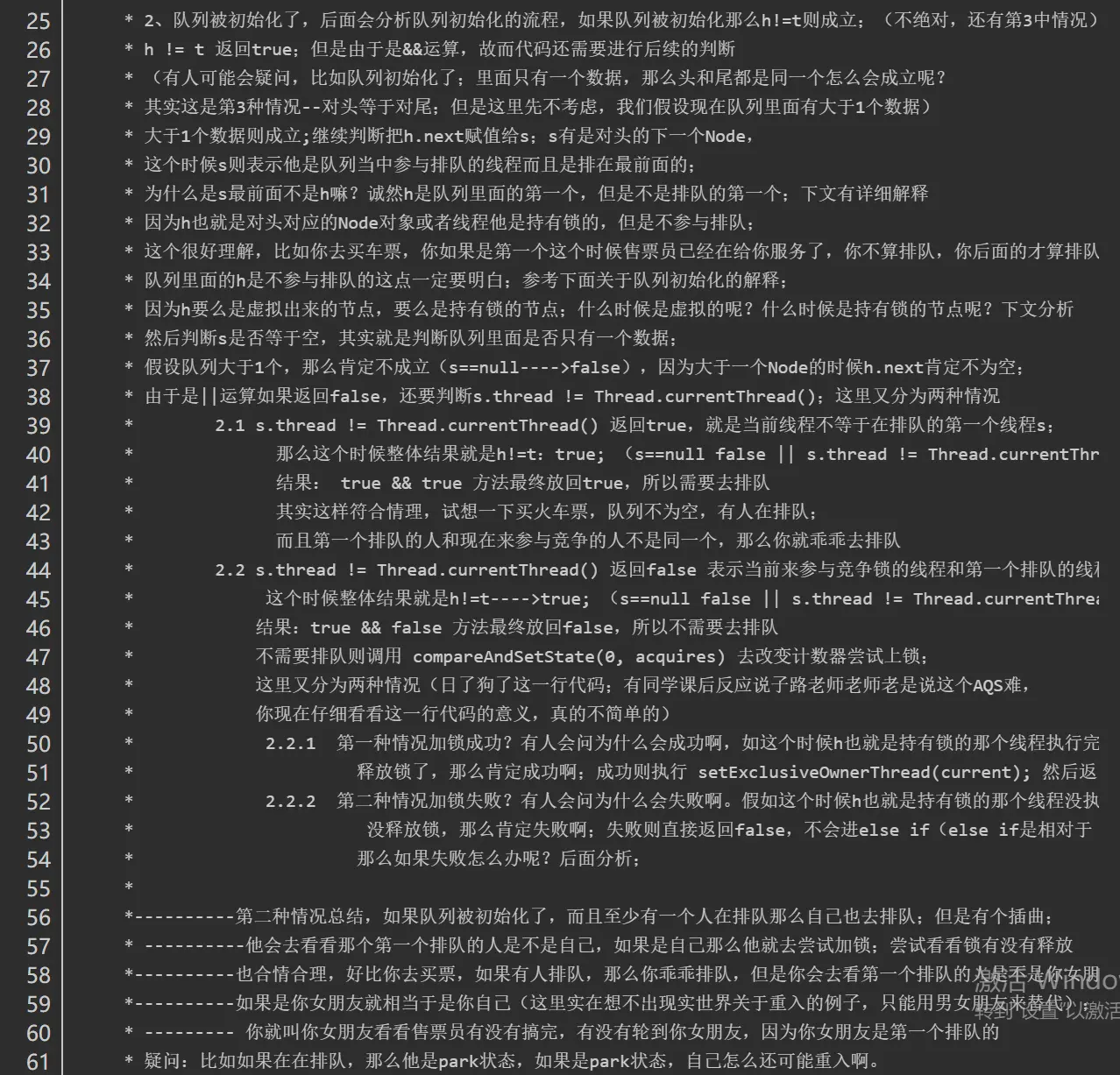

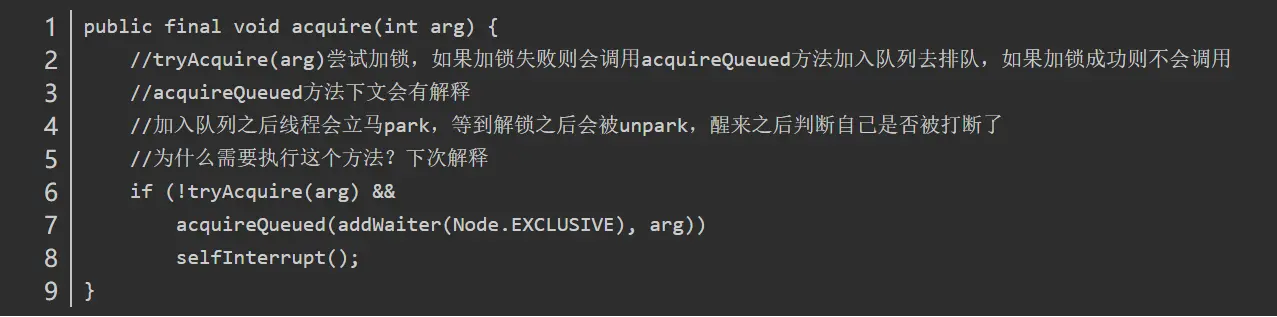

1 | public final void acquire(int arg) { |

关键信息请看注释,acquire根据当前获得同步状态成功与否做了两件事情:

- 成功,则方法结束返回

- 失败,则先调用addWaiter()然后在调用acquireQueued()方法。

获取同步状态失败,入队操作

当线程获取独占式锁失败后就会将当前线程加入同步队列,那么加入队列的方式是怎样的了?

我们接下来就应该去研究一下addWaiter()和acquireQueued()。

addWaiter()源码如下:

1 | private Node addWaiter(Node mode) { |

分析可以看上面的注释。程序的逻辑主要分为两个部分:

- 当前同步队列的尾节点为null,调用方法enq()插入;

- 当前队列的尾节点不为null,则采用尾插入(compareAndSetTail()方法)的方式入队。

另外还会有另外一个问题:如果if (compareAndSetTail(pred, node))为false怎么办?

会继续执行到enq()方法,同时很明显compareAndSetTail是一个CAS操作,通常来说如果CAS操作失败会继续自旋(死循环)进行重试。

因此,经过我们这样的分析,enq()方法可能承担两个任务:

- 处理当前同步队列尾节点为null时进行入队操作;

- 如果CAS尾插入节点失败后负责自旋进行尝试。

那么是不是真的就像我们分析的一样了?只有源码会告诉我们答案:)

enq()源码如下:

1 | private Node enq(final Node node) { |

在上面的分析中我们可以看出在第1步中会先创建头节点,说明同步队列是带头节点的链式存储结构。问1:为什么选择带头节点的链式存储结构?

因为带头节点与不带头节点相比,会在入队和出队的操作中获得更大的便捷性,因此同步队列选择了带头节点的链式存储结构。问2:那么带头节点的队列初始化时机是什么?

自然而然是在tail为null时,即当前线程是第一次插入同步队列。

compareAndSetTail(t, node)方法会利用CAS操作设置尾节点,如果CAS操作失败会在for (;;)for死循环中不断尝试,直至成功return返回为止。

因此,对enq()方法可以做这样的总结:

- 在当前线程是第一个加入同步队列时,调用compareAndSetHead(new Node())方法,完成链式队列的头节点的初始化;

- 自旋不断尝试CAS插入尾节点直至成功为止。

现在我们已经很清楚获取独占式锁失败的线程包装成Node然后插入同步队列的过程了?那么紧接着会有下一个问题?在同步队列中的节点(线程)会做什么事情了来保证自己能够有机会获得独占式锁了?

带着这样的问题我们就来看看acquireQueued()方法,从方法名就可以很清楚,这个方法的作用就是排队获取锁的过程,源码如下:

1 | final boolean acquireQueued(final Node node, int arg) { |

程序逻辑通过注释已经标出,整体来看这是一个这又是一个自旋的过程for (;;),

代码首先获取当前节点的先驱节点,如果先驱节点是头节点的并且成功获得同步状态的时候if (p == head && tryAcquire(arg)),当前节点所指向的线程能够获取锁。反之,获取锁失败设置阻塞状态。

整体示意图为下图:

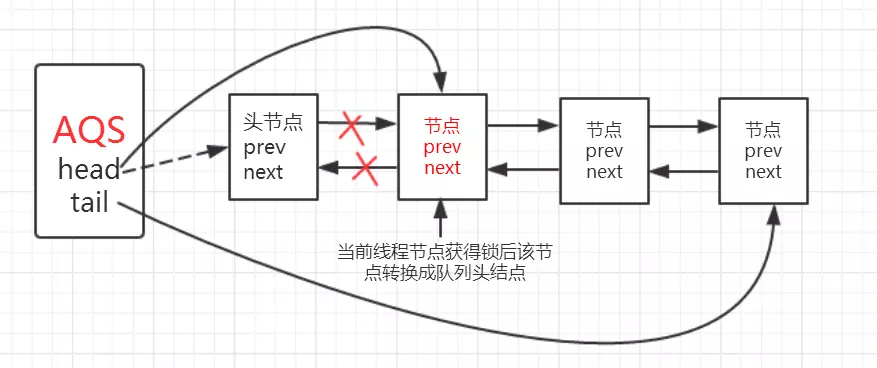

获取锁成功,出队操作

获取锁的节点出队的逻辑是:

1 | setHead(node);// 设置当前节点为头节点 |

setHead()方法为:

1 | private void setHead(Node node) { |

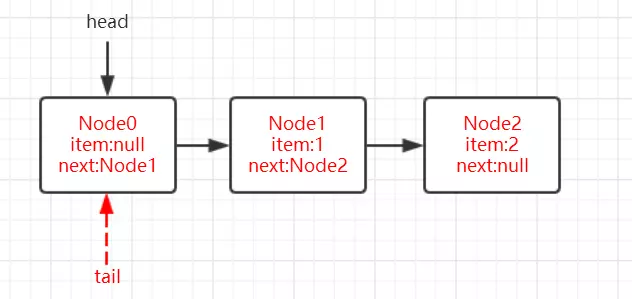

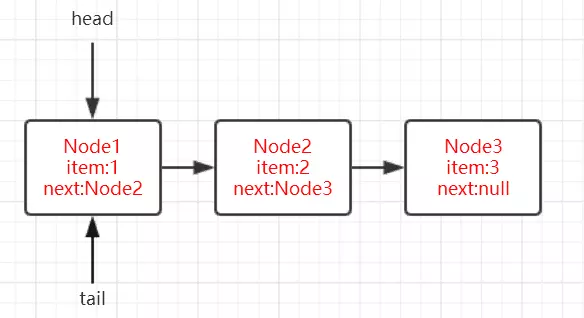

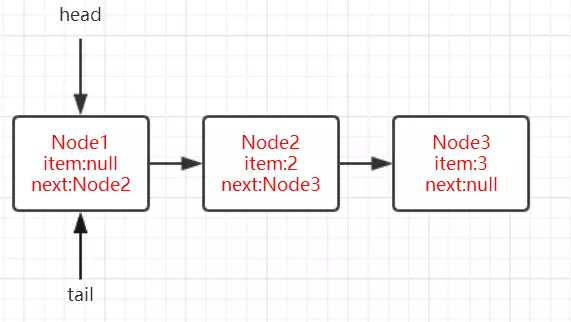

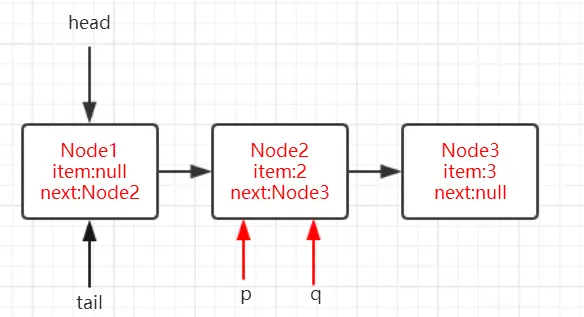

将当前节点通过setHead()方法设置为队列的头节点,然后将之前的头节点的next域设置为null并且pre域也为null,即与队列断开,无任何引用方便GC时能够将内存进行回收。

(设置的第一个节点为null,方便GC回收,设置当前节点为头节点,所以当前节点从第二个节点变为第一个节点,这时前面就没有节点了,所以设置prev为null)

示意图如下:

那么当获取锁失败的时候会调用shouldParkAfterFailedAcquire()方法和parkAndCheckInterrupt()方法,看看他们做了什么事情。

shouldParkAfterFailedAcquire()方法源码为:

1 | private static boolean shouldParkAfterFailedAcquire(Node pred, Node node) { |

waitStatus节点状态

waitStatus节点状态:

1 | 状态字段,只接受值: |

shouldParkAfterFailedAcquire()方法主要逻辑是使用compareAndSetWaitStatus(pred, ws, Node.SIGNAL)使用CAS将节点状态设置成SIGNAL,表示当前线程阻塞。

当compareAndSetWaitStatus设置失败,则说明shouldParkAfterFailedAcquire方法返回false,

然后会在acquireQueued()方法中for (;;)死循环中会继续重试,

直至compareAndSetWaitStatus设置节点状态为SIGNAL时并且shouldParkAfterFailedAcquire返回true时才会执行parkAndCheckInterrupt()方法,

parkAndCheckInterrupt()方法的源码为:

1 | private final boolean parkAndCheckInterrupt() { |

该方法的关键是会调用LookSupport.park()方法(关于LookSupport会在以后的文章进行讨论),该方法是用来阻塞当前线程的。

因此到这里就应该清楚了,acquireQueued()在自旋过程中主要完成了两件事情:

- 如果当前节点的上一个节点是头节点,并且能够获得同步状态的话,方法返回false,就不执行

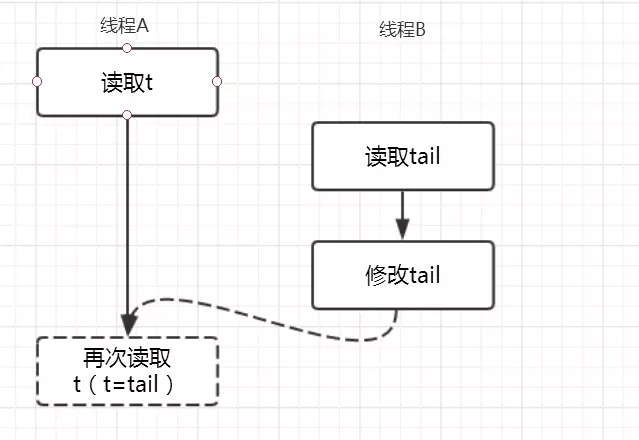

selfInterrupt();,设置当前节点为头节点(获得锁,线程出队) - 获取锁失败的话,先将节点状态设置成SIGNAL,然后调用LookSupport.park方法使得当前线程阻塞